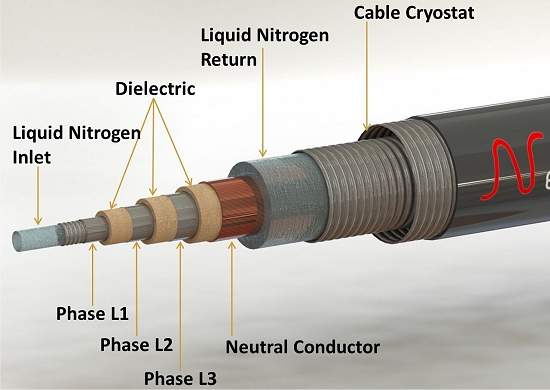

Para atingir sua temperatura ideal de condução, o cabo supercondutor é resfriado com nitrogênio líquido.

Cabo supercondutor

O maior cabo supercondutor do mundo será instalado na Alemanha, unindo duas subestações na cidade de Ruhr.

Projetado para suportar uma carga de 40 MW (megawatts), o cabo será formado por seções concêntricas operando a 10.000 volts.

Segundo engenheiros do Instituto de Tecnologia Karlsruhe, que projetaram o cabo, ele será o primeiro a incorporar um sistema de proteção contra sobrecargas, com limitador de corrente.

O cabo supercondutor terá 1 km de extensão - para se ter uma ideia, o recorde mundial de intensidade de corrente elétrica foi batido com um cabo supercondutor de 30 metros de comprimento.

Espinha dorsal elétrica

Os engenheiros afirmam que cabos supercondutores poderão permitir a completa reestruturação dos sistemas de distribuição de energia nas regiões centrais das cidades.

Isto porque a enorme potência disponibilizada permitirá a criação de uma espécie de espinha dorsal de distribuição elétrica, com inúmeros links de 10 kV derivando desse cabo central para alimentar prédios e outras instalações que precisem de alta tensão.

Embora necessite de um resfriamento a -200º C, toda essa malha de distribuição de energia de alta eficiência exige muito menos espaço do que as redes elétricas atuais, o que é importante em áreas densamente ocupadas, como as regiões centrais das grandes cidades.

Além disso, a possibilidade de falhas e a necessidade de manutenção, segundo os engenheiros alemães, são muito menores.

Transmissão sem perda de energia

De forma surpreendente, os engenheiros calcularam que todo o aparato necessário para o funcionamento do cabo supercondutor, usando nitrogênio líquido para seu resfriamento constante, é uma solução mais barata do que usar cabos de cobre de média tensão.

Segundo eles, o menor custo do cobre é cancelado pela queda ôhmica na rede, que é muito maior.

Para a mesma espessura, o cabo supercondutor transfere 100 vezes mais energia do que o cobre, virtualmente sem perda de energia.

Fonte: Inovação Tecnológica

Pesquisar

terça-feira, 24 de janeiro de 2012

sexta-feira, 20 de janeiro de 2012

Motor híbrido hidrogênio-gasolina consome 20% menos

Hidrox

Dois estudantes espanhóis criaram um motor híbrido a hidrogênio que consome 20% menos combustível do que um motor comum a gasolina.

O motor, de 1,4 litro de cilindrada, recebeu um aparato de geração e combustão de hidrogênio.

O gás é produzido submetendo água a um processo eletrolítico, gerando um gás que é uma mistura de hidrogênio e oxigênio.

O gás é injetado no motor, juntamente com a gasolina - foi utilizado um motor convencional.

O hidrogênio faz com que a explosão da gasolina seja mais forte, enquanto a presença do oxigênio puro amplia a combustão, tudo se juntando para aproveitar melhor o combustível.

Tentativa e erro

Ainda que o motor a hidrogênio já tenha sido inventado, Raúl Novillas e Roger Casas, da Universidade Politécnica da Catalunha, introduziram uma série de modificações no motor comum a gasolina para fazê-lo funcionar melhor com a mistura de hidrogênio e oxigênio.

Segundo eles, essas modificações, a maioria feita na base da tentativa e erro, poderão ser aproveitadas nos futuros veículos a hidrogênio.

A maior dificuldade foi criar um sistema de segurança para trabalhar com o hidrogênio, um gás extremamente inflamável.

Uma exigência básica era criar um compartimento entre o tanque do gás e o tanque de gasolina.

"Depois de alguns sustos e muitas horas de trabalho", eles contam ter encontrado a solução na forma de um depósito de água conectado aos tanques mediante válvulas sem retorno.

Inovação na garagem

Apesar dos bons resultados, o trabalho é bastante preliminar, resultado de um projeto de fim de curso de dois estudantes de graduação, e precisará ser aperfeiçoado antes que se pense em um motor multicombustível que aceite também hidrogênio.

Os próprios estudantes apontam que o rendimento do motor cai depois de cerca de 20 minutos de funcionamento, com a emissão de "substâncias de origem e natureza desconhecidas".

Gerador portátil de hidrogênio produz energia limpa

Eles pretendem continuar a pesquisa, o que exigirá "uma equipe de trabalho maior, sobretudo com a ajuda de um químico, conhecimentos de outras áreas e o apoio de alguma empresa," afirmam.

Também não houve um comparativo de rendimento levando em conta a energia necessária para a eletrólise da água e consequente geração do hidrogênio e oxigênio.

O motor híbrido a hidrogênio foi construído na garagem da casa de um dos estudantes.

Fonte: Inovação Tecnológca

Dois estudantes espanhóis criaram um motor híbrido a hidrogênio que consome 20% menos combustível do que um motor comum a gasolina.

O motor, de 1,4 litro de cilindrada, recebeu um aparato de geração e combustão de hidrogênio.

O gás é produzido submetendo água a um processo eletrolítico, gerando um gás que é uma mistura de hidrogênio e oxigênio.

O gás é injetado no motor, juntamente com a gasolina - foi utilizado um motor convencional.

O hidrogênio faz com que a explosão da gasolina seja mais forte, enquanto a presença do oxigênio puro amplia a combustão, tudo se juntando para aproveitar melhor o combustível.

Tentativa e erro

Ainda que o motor a hidrogênio já tenha sido inventado, Raúl Novillas e Roger Casas, da Universidade Politécnica da Catalunha, introduziram uma série de modificações no motor comum a gasolina para fazê-lo funcionar melhor com a mistura de hidrogênio e oxigênio.

Segundo eles, essas modificações, a maioria feita na base da tentativa e erro, poderão ser aproveitadas nos futuros veículos a hidrogênio.

A maior dificuldade foi criar um sistema de segurança para trabalhar com o hidrogênio, um gás extremamente inflamável.

Uma exigência básica era criar um compartimento entre o tanque do gás e o tanque de gasolina.

"Depois de alguns sustos e muitas horas de trabalho", eles contam ter encontrado a solução na forma de um depósito de água conectado aos tanques mediante válvulas sem retorno.

Inovação na garagem

Apesar dos bons resultados, o trabalho é bastante preliminar, resultado de um projeto de fim de curso de dois estudantes de graduação, e precisará ser aperfeiçoado antes que se pense em um motor multicombustível que aceite também hidrogênio.

Os próprios estudantes apontam que o rendimento do motor cai depois de cerca de 20 minutos de funcionamento, com a emissão de "substâncias de origem e natureza desconhecidas".

Gerador portátil de hidrogênio produz energia limpa

Eles pretendem continuar a pesquisa, o que exigirá "uma equipe de trabalho maior, sobretudo com a ajuda de um químico, conhecimentos de outras áreas e o apoio de alguma empresa," afirmam.

Também não houve um comparativo de rendimento levando em conta a energia necessária para a eletrólise da água e consequente geração do hidrogênio e oxigênio.

O motor híbrido a hidrogênio foi construído na garagem da casa de um dos estudantes.

Fonte: Inovação Tecnológca

quarta-feira, 18 de janeiro de 2012

Brasil é o país que produz energia eólica mais barata

Com capacidade para produzir o triplo de toda a energia que consumimos hoje, a eólica ganha cada vez mais espaço no Brasil, que já é considerado o país que transforma vento em eletricidade pelo menor preço do mundo – e o custo da produção ainda pode ser barateado no próximo mês

Se os entusiastas da energia eólica tivessem que escolher um ano, seria 2011: nos últimos 36 meses, a renovável tem aumentado sua competitividade no Brasil, graças ao crescimento da produtividade e diminuição dos custos de geração, mas foi neste ano que a fonte de energia limpa se consagrou no país, ao ser considerada, no último leilão de energia elétrica promovido pelo governo federal, a segunda fonte de energia mais barata do país, perdendo, apenas, para a hídrica.

Quem contou, em tom de comemoração, foi Elbia Melo, diretora-presidente executiva da ABEEOLICA - Associação Brasileira de Energia Eolica, durante o EXAME Fórum Energia, que aconteceu nesta segunda-feira, 21/11, em São Paulo e debateu, entre outro temas, o crescimento das energias renováveis no Brasil. De acordo com a especialista, atualmente o preço da produção de energia eólica no país é de R$ 99,64 por kWh - valor 66% inferior ao de sete ano atrás -, dando ao Brasil o título de nação que produz a energia eólica mais barata do mundo, segundo dados do MME - Ministério de Minas e Energia.

"Todo esse crescimento do setor não aconteceu por mágica. O Brasil investiu muito em aprendizado tecnológico desde 2004 com o Proinfa - Programa Nacional de Incentivo às Fontes Alternativas de Energia Elétrica e, como consequência, conseguiu progredir do ponto de vista técnico e aumentar sua capacidade de geração de energia eólica", disse Melo, que citou, como exemplo do avanço brasileiro no setor, o incremento do tamanho das torres de captação de vento, que, em seis anos, passaram de 52 para 100 metros.

A especialista ainda atribui o atual preço baixo na produção de energia eólica no Brasil a outros dois fatores:

- o modelo de leilão de energia elétrica promovido pelo governo, que estimula a competição entre as empresas do setor ao colocá-las frente a frente para expor seus custos de produção e, portanto, incentiva o barateamento do processo e

- a crise econômica, que inibiu os investimentos de diversos países em energia eólica, dando ao Brasil o título de 3ª nação que mais produz eletricidade por meio dos ventos, atrás, apenas, da China e da Índia.

"Com isso, nosso país passa a ser um dos únicos lócus para os investimentos das indústrias do setor. Estamos atraindo empresas internacionais, que, inclusive, estão barateando seus preços para aumentar a competitividade", contou Melo, que ainda afirmou que esse cenário pode proporcionar uma redução ainda maior nos custos para a geração de energia eólica no país: "Em dezembro teremos um novo leilão e todos se perguntam se o preço da produção poderá baixar ainda mais. Muitos duvidam, mas o mercado é imprevisível e várias empresas ainda querem ingressar no setor. Então há, sim, grandes chances de baratear ainda mais o processo".

NÃO DÁ PARA VIVER SÓ DE VENTO

Com custos de produção favoráveis e capacidade eólica para produzir 300 GW de energia - quase o triplo da capacidade de produção atual da matriz energética brasileira -, por que não transformar o vento na nossa principal, se não única, fonte de energia? Melo explica: "Apesar de todo seu potencial, uma das principais características da energia eólica é a sazonalidade, ou seja, ela não está disponível sempre que precisamos e, portanto, assim como todas as outras fontes alternativas, precisa de outras formas de energia para poder se fixar na matriz energética", disse a especialista, que ainda completou: "É ilusão pensar que vamos aumentar a oferta de energia apenas com alternativas limpas. Infelizmente, a realidade é que, à medida que o consumo cresce, precisamos de mais fontes para obter energia - incluindo as não tão ecologicamente corretas, como as termelétricas".

Nesse caso, o ideal para termos uma matriz energética que seja o mais limpa possível é investir, ao máximo, nas fontes ainda não convencionais de energia, como a solar, de biomassa e as PCHs - Pequenas Centrais Hidrelétricas, além, claro, da eólica. "E a melhor maneira de fazer esse mix de energia limpa na nossa matriz é investir em leilões específicos para as novas renováveis. Os atuais leilões não abrem espaço para essas fontes de energia, portanto eventos mais focados são uma forma de incentivá-las, para que no futuro estejam em uma posição tão confortável quanto a eólica, hoje", disse Osvaldo Soliano, professor da Unifacs - Universidade Salvador e especialista em energia eólica e solar, que também participou do EXAME Fórum Energia.

Fonte: Planetasustentável

Se os entusiastas da energia eólica tivessem que escolher um ano, seria 2011: nos últimos 36 meses, a renovável tem aumentado sua competitividade no Brasil, graças ao crescimento da produtividade e diminuição dos custos de geração, mas foi neste ano que a fonte de energia limpa se consagrou no país, ao ser considerada, no último leilão de energia elétrica promovido pelo governo federal, a segunda fonte de energia mais barata do país, perdendo, apenas, para a hídrica.

Quem contou, em tom de comemoração, foi Elbia Melo, diretora-presidente executiva da ABEEOLICA - Associação Brasileira de Energia Eolica, durante o EXAME Fórum Energia, que aconteceu nesta segunda-feira, 21/11, em São Paulo e debateu, entre outro temas, o crescimento das energias renováveis no Brasil. De acordo com a especialista, atualmente o preço da produção de energia eólica no país é de R$ 99,64 por kWh - valor 66% inferior ao de sete ano atrás -, dando ao Brasil o título de nação que produz a energia eólica mais barata do mundo, segundo dados do MME - Ministério de Minas e Energia.

"Todo esse crescimento do setor não aconteceu por mágica. O Brasil investiu muito em aprendizado tecnológico desde 2004 com o Proinfa - Programa Nacional de Incentivo às Fontes Alternativas de Energia Elétrica e, como consequência, conseguiu progredir do ponto de vista técnico e aumentar sua capacidade de geração de energia eólica", disse Melo, que citou, como exemplo do avanço brasileiro no setor, o incremento do tamanho das torres de captação de vento, que, em seis anos, passaram de 52 para 100 metros.

A especialista ainda atribui o atual preço baixo na produção de energia eólica no Brasil a outros dois fatores:

- o modelo de leilão de energia elétrica promovido pelo governo, que estimula a competição entre as empresas do setor ao colocá-las frente a frente para expor seus custos de produção e, portanto, incentiva o barateamento do processo e

- a crise econômica, que inibiu os investimentos de diversos países em energia eólica, dando ao Brasil o título de 3ª nação que mais produz eletricidade por meio dos ventos, atrás, apenas, da China e da Índia.

"Com isso, nosso país passa a ser um dos únicos lócus para os investimentos das indústrias do setor. Estamos atraindo empresas internacionais, que, inclusive, estão barateando seus preços para aumentar a competitividade", contou Melo, que ainda afirmou que esse cenário pode proporcionar uma redução ainda maior nos custos para a geração de energia eólica no país: "Em dezembro teremos um novo leilão e todos se perguntam se o preço da produção poderá baixar ainda mais. Muitos duvidam, mas o mercado é imprevisível e várias empresas ainda querem ingressar no setor. Então há, sim, grandes chances de baratear ainda mais o processo".

NÃO DÁ PARA VIVER SÓ DE VENTO

Com custos de produção favoráveis e capacidade eólica para produzir 300 GW de energia - quase o triplo da capacidade de produção atual da matriz energética brasileira -, por que não transformar o vento na nossa principal, se não única, fonte de energia? Melo explica: "Apesar de todo seu potencial, uma das principais características da energia eólica é a sazonalidade, ou seja, ela não está disponível sempre que precisamos e, portanto, assim como todas as outras fontes alternativas, precisa de outras formas de energia para poder se fixar na matriz energética", disse a especialista, que ainda completou: "É ilusão pensar que vamos aumentar a oferta de energia apenas com alternativas limpas. Infelizmente, a realidade é que, à medida que o consumo cresce, precisamos de mais fontes para obter energia - incluindo as não tão ecologicamente corretas, como as termelétricas".

Nesse caso, o ideal para termos uma matriz energética que seja o mais limpa possível é investir, ao máximo, nas fontes ainda não convencionais de energia, como a solar, de biomassa e as PCHs - Pequenas Centrais Hidrelétricas, além, claro, da eólica. "E a melhor maneira de fazer esse mix de energia limpa na nossa matriz é investir em leilões específicos para as novas renováveis. Os atuais leilões não abrem espaço para essas fontes de energia, portanto eventos mais focados são uma forma de incentivá-las, para que no futuro estejam em uma posição tão confortável quanto a eólica, hoje", disse Osvaldo Soliano, professor da Unifacs - Universidade Salvador e especialista em energia eólica e solar, que também participou do EXAME Fórum Energia.

Fonte: Planetasustentável

domingo, 15 de janeiro de 2012

A luz vai ficar smart

No final de 2012 ou no início de 2013, começam a ser instaladas as redes inteligentes, que permitirão a cobrança diferenciada de tarifas

Se tudo ocorrer conforme o cronograma traçado pela Agência Nacional de Energia Elétrica (Aneel), as smart grids, ou redes inteligentes, devem começar a ser implantadas no país entre o final de 2012 e o início de 2013. O processo deve se iniciar com a troca dos medidores eletromecânicos atuais por modelos eletrônicos, que vão facilitar o controle do consumo tanto pelos clientes quanto pelas empresas distribuidoras de energia. Os novos equipamentos permitirão que o consumidor saiba, em tempo real, quanto está gastando de energia. A ideia é que a substituição dos medidores venha acompanhada pela adoção de tarifas diferenciadas por horário para clientes residenciais. Com a cobrança de tarifas mais caras no período de maior consumo, os clientes serão incentivados a gastar menos energia no horário de pico - o consumidor poderá, por exemplo, programar a lavadora de roupas para funcionar de madrugada ou reduzir a potência do ar-condicionado nos horários em que a energia for mais cara.

A Aneel pretende regulamentar o uso dos novos medidores eletrônicos nos próximos meses. O Brasil possui atualmente 67 milhões de medidores de energia, que deverão ser substituídos num prazo de até dez anos, dependendo do ritmo de implantação das redes inteligentes pelas distribuidoras. O custo de cada novo medidor é estimado em cerca de 200 reais, o que significa um investimento de mais de 13 bilhões de reais para a troca de todos os equipamentos. Ainda não está definido quem vai pagar essa conta. A intenção da Aneel é que as distribuidoras de energia realizem a troca sem repassar os custos ao consumidor, uma vez que as empresas terão, de acordo com a agência, enormes ganhos de eficiência - poderão monitorar o consumo mais facilmente, detectar os desvios de energia (os gatos) e realizar cortes sem necessidade de enviar um funcionário até a residência.

Fonte: Planetasustentável

Se tudo ocorrer conforme o cronograma traçado pela Agência Nacional de Energia Elétrica (Aneel), as smart grids, ou redes inteligentes, devem começar a ser implantadas no país entre o final de 2012 e o início de 2013. O processo deve se iniciar com a troca dos medidores eletromecânicos atuais por modelos eletrônicos, que vão facilitar o controle do consumo tanto pelos clientes quanto pelas empresas distribuidoras de energia. Os novos equipamentos permitirão que o consumidor saiba, em tempo real, quanto está gastando de energia. A ideia é que a substituição dos medidores venha acompanhada pela adoção de tarifas diferenciadas por horário para clientes residenciais. Com a cobrança de tarifas mais caras no período de maior consumo, os clientes serão incentivados a gastar menos energia no horário de pico - o consumidor poderá, por exemplo, programar a lavadora de roupas para funcionar de madrugada ou reduzir a potência do ar-condicionado nos horários em que a energia for mais cara.

A Aneel pretende regulamentar o uso dos novos medidores eletrônicos nos próximos meses. O Brasil possui atualmente 67 milhões de medidores de energia, que deverão ser substituídos num prazo de até dez anos, dependendo do ritmo de implantação das redes inteligentes pelas distribuidoras. O custo de cada novo medidor é estimado em cerca de 200 reais, o que significa um investimento de mais de 13 bilhões de reais para a troca de todos os equipamentos. Ainda não está definido quem vai pagar essa conta. A intenção da Aneel é que as distribuidoras de energia realizem a troca sem repassar os custos ao consumidor, uma vez que as empresas terão, de acordo com a agência, enormes ganhos de eficiência - poderão monitorar o consumo mais facilmente, detectar os desvios de energia (os gatos) e realizar cortes sem necessidade de enviar um funcionário até a residência.

Fonte: Planetasustentável

sábado, 14 de janeiro de 2012

VEÍCULOS VERDES

5 previsões para os carros elétricos em 2012

Depois de roubar a cena nos salões de automóveis em 2011, os veículos ecológicos devem ganhar mais atenção este ano; preços ainda serão entrave à popularização.

Sai ano, entra ano, e os quatro-rodas verdes continuam a atrair olhares desconfiados de muita gente. Mas pouco a pouco, o mercado vem se empenhando em mudar essa imagem de algo "fantasioso e inviável" associada aos modelos elétricos e híbridos. Depois de roubar a cena nos salões de automóveis em 2011, os veículos ecológicos devem ganhar mais atenção este ano.

Segundo previsões da consultoria PikeResearch, especializada em tecnologias limpas, as versões verdes devem seduzir novos adeptos principalmente a partir de programas de aluguel de carros, os chamados car sharing, e também por incentivos empresariais. O desafio será batalhar por preços mais acessíveis. Os valores salgados ainda assustam e impedem a popularização dos verdinhos. Confira a seguir cinco tendências identificadas pela consultoria para os elétricos:

1 - ELES VIERAM PARA FICAR

O aumento da disponibilidade e variedade de modelos elétricos e híbridos vai pôr um fim nas especulações sobre a viabilidade da tecnologia. Segundo a Pike Research, o ano de 2012 marcará a transição dos elétricos de um tempo de disponibilidade limitada (tanto em volume quanto em geografia) para uma alternativa de transporte sustentável e crível. Estima-se que as vendas globais de carros elétricos vão superar 257 mil unidades este ano. São esperados os primeiros lançamentos comerciais de versões ecológicas da BMW, Ford, Honda e Volvo.

2 - PROGRAMAS DE CAR SHARING VÃO ESQUENTAR O MERCADO

Os serviços de aluguel de carros por períodos determinados prometem aquecer o mercado de modelos ecologicamente corretos. Isso porque, em grandes centros urbanos, esse tipo de programa vem sendo considerado um aliado para redução dos níveis de poluição. Claro que não são todos que oferecem carros elétricos, mas alguns importantes, como o Autolib, em Paris, e o City Car Share, em São Francisco, nos EUA, usam apenas modelos ecológicos. Com isso, quem nunca dirigiu um elétrico mas simpatiza com a proposta pode alugar os veículos e se divertir, e mesmo aqueles mais céticos em relação à tecnologia podem experimentar e, quem sabe, acabar gostando.

3 - ENERGIA PARA DAR E VENDER

Imagine poder vender para a rede elétrica a energia acumulada na bateria do carro. Grosso modo, essa é a ideia do V2G (Vehicle to Grid), uma tecnologia ainda embrionária, mas que deve se tornar realidade em 2012, ainda que de forma tímida.

Por concentrar quase metade do mercado de elétricos em 2012, os países da região Ásia-Pacífico deverão implementar os primeiros testes com V2G. Na esteira do tsunami e terremoto que abalaram o Japão em março passado, grupos como Nissan e Mitsubishi decidiram desenvolver equipamentos que permitam aos veículos fornecer energia a um edifício em situações de emergências, quando a rede elétrica fica indisponível.

4 - PREÇOS CONTINUARÃO A DECEPCIONAR

Os valores salgados da maior parte dos carros elétricos e híbridos continuarão depondo contra a popularização dos modelos ecológicos em todo mundo. De acordo com uma pesquisa de consumo da Pike Research, o preço ideal para os elétricos se tornarem atraentes e acessíveis à população gira em torno de 23 mil dólares. Na prática, as cifras são maiores. O Toyota Prius, por exemplo, custa em média 32 mil dólares, já a versão elétrica do Honda Fit vai a 36 mil dólares, enquanto o Ford Focus EV custa quase o dobro do ideal, cerca de 40 mil dólares.

5 - EMPRESAS VÃO APOSTAR NA MOTORIZAÇÃO VERDE

Que tal ganhar um incentivo para ir trabalhar com um carro elétrico? Essa é mais umas das tendências para o mercado em 2012, especialmente na Europa e na Ásia Pacífico. O estudo prevê que empregadores à procura de atrair e reter profissionais vão começar a oferecer gratuitamente ou a baixo custo recarga elétrica. Nos Estados Unidos, empresas como a Adobe, SAP, e Google já disponibilizam carregadores em suas instalações.

Fonte: planetasustentavel

Depois de roubar a cena nos salões de automóveis em 2011, os veículos ecológicos devem ganhar mais atenção este ano; preços ainda serão entrave à popularização.

Sai ano, entra ano, e os quatro-rodas verdes continuam a atrair olhares desconfiados de muita gente. Mas pouco a pouco, o mercado vem se empenhando em mudar essa imagem de algo "fantasioso e inviável" associada aos modelos elétricos e híbridos. Depois de roubar a cena nos salões de automóveis em 2011, os veículos ecológicos devem ganhar mais atenção este ano.

Segundo previsões da consultoria PikeResearch, especializada em tecnologias limpas, as versões verdes devem seduzir novos adeptos principalmente a partir de programas de aluguel de carros, os chamados car sharing, e também por incentivos empresariais. O desafio será batalhar por preços mais acessíveis. Os valores salgados ainda assustam e impedem a popularização dos verdinhos. Confira a seguir cinco tendências identificadas pela consultoria para os elétricos:

1 - ELES VIERAM PARA FICAR

O aumento da disponibilidade e variedade de modelos elétricos e híbridos vai pôr um fim nas especulações sobre a viabilidade da tecnologia. Segundo a Pike Research, o ano de 2012 marcará a transição dos elétricos de um tempo de disponibilidade limitada (tanto em volume quanto em geografia) para uma alternativa de transporte sustentável e crível. Estima-se que as vendas globais de carros elétricos vão superar 257 mil unidades este ano. São esperados os primeiros lançamentos comerciais de versões ecológicas da BMW, Ford, Honda e Volvo.

2 - PROGRAMAS DE CAR SHARING VÃO ESQUENTAR O MERCADO

Os serviços de aluguel de carros por períodos determinados prometem aquecer o mercado de modelos ecologicamente corretos. Isso porque, em grandes centros urbanos, esse tipo de programa vem sendo considerado um aliado para redução dos níveis de poluição. Claro que não são todos que oferecem carros elétricos, mas alguns importantes, como o Autolib, em Paris, e o City Car Share, em São Francisco, nos EUA, usam apenas modelos ecológicos. Com isso, quem nunca dirigiu um elétrico mas simpatiza com a proposta pode alugar os veículos e se divertir, e mesmo aqueles mais céticos em relação à tecnologia podem experimentar e, quem sabe, acabar gostando.

3 - ENERGIA PARA DAR E VENDER

Imagine poder vender para a rede elétrica a energia acumulada na bateria do carro. Grosso modo, essa é a ideia do V2G (Vehicle to Grid), uma tecnologia ainda embrionária, mas que deve se tornar realidade em 2012, ainda que de forma tímida.

Por concentrar quase metade do mercado de elétricos em 2012, os países da região Ásia-Pacífico deverão implementar os primeiros testes com V2G. Na esteira do tsunami e terremoto que abalaram o Japão em março passado, grupos como Nissan e Mitsubishi decidiram desenvolver equipamentos que permitam aos veículos fornecer energia a um edifício em situações de emergências, quando a rede elétrica fica indisponível.

4 - PREÇOS CONTINUARÃO A DECEPCIONAR

Os valores salgados da maior parte dos carros elétricos e híbridos continuarão depondo contra a popularização dos modelos ecológicos em todo mundo. De acordo com uma pesquisa de consumo da Pike Research, o preço ideal para os elétricos se tornarem atraentes e acessíveis à população gira em torno de 23 mil dólares. Na prática, as cifras são maiores. O Toyota Prius, por exemplo, custa em média 32 mil dólares, já a versão elétrica do Honda Fit vai a 36 mil dólares, enquanto o Ford Focus EV custa quase o dobro do ideal, cerca de 40 mil dólares.

5 - EMPRESAS VÃO APOSTAR NA MOTORIZAÇÃO VERDE

Que tal ganhar um incentivo para ir trabalhar com um carro elétrico? Essa é mais umas das tendências para o mercado em 2012, especialmente na Europa e na Ásia Pacífico. O estudo prevê que empregadores à procura de atrair e reter profissionais vão começar a oferecer gratuitamente ou a baixo custo recarga elétrica. Nos Estados Unidos, empresas como a Adobe, SAP, e Google já disponibilizam carregadores em suas instalações.

Fonte: planetasustentavel

Energia Eólica: saiba o que é e como funciona.

Informações Gerais

Denomina-se energia eólica a energia cinética contida nas massas de ar em movimento (vento). Seu aproveitamento ocorre por meio da

conversão da energia cinética de translação em energia cinética de rotação, com o emprego de turbinas eólicas, também denominadas

aerogeradores, para a geração de eletricidade, ou cataventos (e moinhos), para trabalhos mecânicos como bombeamento d’água.

Assim como a energia hidráulica, a energia eólica é utilizada há milhares de anos com as mesmas finalidades, a saber: bombeamento de água, moagem de grãos e outras aplicações que envolvem energia mecânica. Para a geração de eletricidade, as primeiras tentativas surgiram no final do século XIX, mas somente um século depois, com a crise internacional do petróleo (década

de 1970), é que houve interesse e investimentos suficientes para viabilizar o desenvolvimento e aplicação de equipamentos em

escala comercial.

A primeira turbina eólica comercial ligada à rede elétrica pública foi instalada em 1976, na Dinamarca. Atualmente, existem mais

de 30 mil turbinas eólicas em operação no mundo. Em 1991, a Associação Européia de Energia Eólica estabeleceu como metas a

instalação de 4.000 MW de energia eólica na Europa até o ano 2000 e 11.500 MW até o ano 2005. Essas e outras metas estão

sendo cumpridas muito antes do esperado (4.000 MW em 1996, 11.500 MW em 2001). As metas atuais são de 40.000 MW na

Europa até 2010. Nos Estados Unidos, o parque eólico existente é da ordem de 4.600 MW instalados e com um crescimento anual

em torno de 10%. Estima-se que em 2020 o mundo terá 12% da energia gerada pelo vento, com uma capacidade instalada de

mais de 1.200GW (WINDPOWER; EWEA; GREENPEACE, 2003; WIND FORCE, 2003).

Recentes desenvolvimentos tecnológicos (sistemas avançados de transmissão, melhor aerodinâmica, estratégias de controle e operação das

turbinas etc.) têm reduzido custos e melhorado o desempenho e a confiabilidade dos equipamentos. O custo dos equipamentos, que era

um dos principais entraves ao aproveitamento comercial da energia eólica, reduziu-se significativamente nas últimas duas décadas. Projetos eólicos em 2002, utilizando modernas turbinas eólicas em condições favoráveis, apresentaram custos na ordem de 820/kW instalado e produção de energia a 4 cents/kWh (EWEA; GREENPEACE, 2003).

Potencial Eólico Brasileiro

Embora ainda haja divergências entre especialistas e instituições na estimativa do potencial eólico brasileiro, vários estudos indicam valores extremamente consideráveis. Até poucos anos, as estimativas eram da

ordem de 20.000 MW. Hoje a maioria dos estudos indica valores maiores que 60.000 MW. Essas divergências decorrem principalmente da

falta de informações (dados de superfície) e das diferentes metodologias

empregadas (19).

De qualquer forma, os diversos levantamentos e estudos realizados e em

andamento (locais, regionais e nacionais) têm dado suporte e motivado

a exploração comercial da energia eólica no País. Os primeiros estudos

foram feitos na região Nordeste, principalmente no Ceará e em Pernambuco. Com o apoio da ANEEL e do Ministério de Ciência e Tecnologia –

MCT, o Centro Brasileiro de Energia Eólica – CBEE, da Universidade Federal de Pernambuco – UFPE, publicou em 1998 a primeira versão do

Atlas Eólico da Região Nordeste. A continuidade desse trabalho resultou

no Panorama do Potencial Eólico no Brasil, conforme Figura 6.1 .

Os recursos apresentados na legenda da Figura 6.1 referem-se à velocidade média do vento e energia eólica média a uma altura de 50m acima da

superfície para 5 condições topográficas distintas: zona costeira – áreas

de praia, normalmente com larga faixa de areia, onde o vento incide predominantemente do sentido mar-terra; campo aberto – áreas planas de

pastagens, plantações e /ou vegetação baixa sem muitas árvores altas;

mata – áreas de vegetação nativa com arbustos e árvores altas mas de

baixa densidade, tipo de terreno que causa mais obstruções ao fluxo de

vento; morro – áreas de relevo levemente ondulado, relativamente complexo, com pouca vegetação ou pasto; montanha – áreas de relevo complexo, com altas montanhas.

Ainda na legenda, a classe 1 representa regiões de baixo potencial eólico, de pouco ou nenhum interesse para o aproveitamento da energia eó-

lica. A classe 4 corresponde aos melhores locais para aproveitamento dos

ventos no Brasil. As classes 2 e 3 podem ou não ser favoráveis, dependendo das condições topográficas. Por exemplo: um local de classe 3 na

costa do Nordeste (zona costeira) pode apresentar velocidades médias

anuais entre 6,5 e 8 m/s, enquanto que um local de classe 3 no interior

do Maranhão (mata) apresentará apenas valores entre 4,5 e 6 m/s.

A Tabela 6.3 mostra a classificação das velocidades de vento e regiões

topográficas utilizadas no mapa da Figura 6.1. Os valores correspondem à velocidade média anual do vento a 50 m de altura em m/s (Vm)

e à densidade média de energia média em W/m2 (Em).

Os valores deEm foram obtidos para as seguintes condições padrão: altitude igual

ao nível do mar, temperatura de 20ºC e fator de Weibull de 2,5. A mudança de altitude para 1.000 m acima do nível do mar acarreta uma

diminuição de 9% na densidade média de energia e a diminuição de

temperatura para 15ºC provoca um aumento de cerca de 2% na densidade de energia média.

Outro estudo importante, em âmbito nacional, foi publicado pelo Centro de Referência para Energia Solar e Eólica – CRESESB/CEPEL. Trata-se

do Atlas do Potencial Eólico Brasileiro, cujos resultados estão disponíveis

no seguinte endereço eletrônico: www.cresesb.cepel.br/atlas_eolico_brasil/atlas-web.htm. Nesse estudo estimou-se um potencial eólico

brasileiro da ordem de 143 GW. Existem também outros estudos especí-

ficos por unidades da Federação, desenvolvidos por iniciativas locais.

Há mais vantagens que desvantagens na Energia Eólica, neste artigo listamos as principais vantagens e desvantagens da energia eólica. Hoje, a energia eólica é uma das fontes de energia que mais crescem do mundo, e vista de ser uma fonte renovável de energia, que utiliza do vento, uma fonte de energia que nunca se esgotará, em contraste com o petróleo, por exemplo, que tem seus dias contados. Há diversas pesquisas científicas para tornar mais eficiente e economico o uso da energia eólica. Veja neste artigo as principais vantagens e desvantagens da Enegria Eólica.

Como funciona a energia eólica?

O vento gira uma hélice gigante conectada a um gerador que produz eletricidade. Quando vários mecanismos como esse - conhecido como turbina de vento - são ligados a uma central de transmissão de energia, temos uma central eólica. A quantidade de energia produzida por uma turbina varia de acordo com o tamanho das suas hélices e, claro, do regime de ventos na região em que está instalada. E não pense que o ideal é contar simplesmente com ventos fortes. "Além da velocidade dos ventos, é importante que eles sejam regulares, não sofram turbulências e nem estejam sujeitos a fenômenos climáticos como tufões", diz o engenheiro mecânico Everaldo Feitosa, vice-presidente da Associação Mundial de Energia Eólica.

O Brasil tem um dos maiores potenciais eólicos do planeta e, embora hoje o vento seja responsável por míseros 29 megawatts (MW) dos cerca de 92 mil MW instalados no país, há planos ambiciosos para exploração dessa fonte de energia. Apoiado no Programa de Incentivo às Fontes Alternativas de Energia (Proinfa), lançado pelo Ministério de Minas e Energia, o Brasil pretende atingir, em 2008, cerca de 1.500 MW gerados pelo vento - um terço disso será instalado no Ceará e deve suprir mais da metade da demanda do estado.

O que impede a instalação de mais centrais eólicas ainda éo preço. A energia gerada por uma central eólica custa entre 60% e 70% a mais que a mesma quantidade gerada por uma usina hidrelétrica. Por outro lado, a energia do vento tem a grande vantagem de ser inesgotável e causar pouquíssimo impacto ao ambiente.

Vantagens da Energia Eólica

O vento é uma fonte de combustível é limpa e renovável, não causa nenhum tipo de poluição na atmosfera ou no meio ambiente, e sempre vai existir, nunca acabará, pois o vento é um fenômeno natural da natureza, causado por diversos fatores relacionados ao formato e fluxos de fenômenos do mundo. Usinas de energias podem queimar combustíveis fósseis, como carvão ou gás natural, que são energias que acabam e são poluentes. Esta é a primeira e mais aparente vantagem da energia eólica.

A segunda grande vantagem, é que a energia eólica é uma das ténologias de energias mais baratas disponíveis no mercado, tendo cada quilowatt por hora uito mais barato que outras energias. Obviamente, as economias dependem do investimento inicial, da estrutura da sua geração de energia eólica.

Desvantagens da Energia Eólica

Com nem tudo são flores na vida, a Energia Eólica tem algumas desvantagens, apesar das desvantagens da Energia Eólica não serem motivo para você não usar, na maioria dos casos.

A primeira desvantagem é que pra financiar um sistema de geração de energia eólica é um pouco caro, há cada ano a técnologia relacionada aos equipamentos de energia eólica vêm ficando mais sofisticados e baratos, mas ainda assim este é um tipo de energia que não consegue competir com outros tipos de energia de implementação mais barata. Mas lembro que é apenas um investimento inicial, uma vez que é uma forma de enrgia mais barata que outras formas encontradas no mercado.

Outras desvantagens é que luhares com um bom vento geralmente estão localizados em lugares mais remotos, longes de cidades, onde é necessário a eletrecidade elétrica. Esta é outra desvatagens e que faz a energia elétrica gerada pela energia eólica um tanto inviável para algumas cidades, mas um tanto aproveitável por muitos habitantes de zonas rurais.

Fonte: Aneel, http://planetasustentavel.abril.com.br.

sexta-feira, 13 de janeiro de 2012

Sonho da inteligência artificial continua

Os serviços parecem estar ficando melhores. Mas robôs conscientes ainda pertencem ao reino da ficção científica.

Cérebro de siri

Em 1984, o cineasta James Cameron imaginou um mundo no qual computadores adquiriam inteligência artificial, passando a destruir sistematicamente a humanidade.

O sistema Skynet, de "O Exterminador do Futuro", iria destruir o mundo em 2011.

Sobrevivemos sem nenhum cataclisma a 2011 e o mais próximo que chegamos dos computadores com inteligência artificial foi com o Siri, da Apple.

O Siri não se promove como sendo inteligente, embora prometa ouvir e aprender e, tomara, resolva não nos destruir.

Parece que em 2012 um computador irá passar pelo Teste de Turing, o exame que detecta sistemas inteligentes, deixando-nos mais próximos da inteligência artificial plena.

Ironicamente, a maioria das pessoas não irá se importar com isso.

Máquinas que cuidam

Impressiona a forma como o debate em torno dos objetivos do "computador-humano" se descolou do Teste de Turing e da noção de que uma máquina pareça humana ao estimular o pensamento e a interpretação.

Por ora, queremos mais. Queremos máquinas que cuidem das pessoas e não apenas que pensem como nós. Máquinas que cuidem de nossos interesses.

Há sinais de que tais máquinas já estão no horizonte, o que é bom.

Os equipamentos digitais que nos rodeiam ainda são muito inseguros e requerem garantias constantes. Os atuais sistemas ainda dependem de muita coisa: energia, conectividade, senhas, conteúdos, etc.

Às vezes penso que se nossos equipamentos fossem pessoas, seriam de difícil manutenção. Nos perguntaríamos se não valeria a pena romper com eles.

O problema se torna mais agudo se continuarmos a adquirir mais aparelhos no ritmo atual - e nós continuaremos. Se há um limite para quantos dispositivos e serviços queremos em nossas vidas, não parece que já o tenhamos descoberto.

Máquinas conscientes?

Acho, no entanto, que em 2012 começaremos a ver sinais de mudança em nossa relação com esses equipamentos.

Não falo apenas de novas formas de interface e interação. Há menos sobre reconhecimento de voz e gesto e mais sobre máquinas que são contextualmente conscientes.

E há muita tecnologia séria no trabalho para fazer com que isso aconteça - câmeras que sabem como fazer você aparecer no seu melhor estado, serviços inteligentes que sabem suas preferências e fazem as melhores escolhas para lhe agradar e surpreender.

Creio que estamos vendo nossa interação com os serviços digitais amadurecendo para algo mais próximo a uma relação e menos a algo de trabalho árduo.

Mais do mesmo

Claro, muito disso ainda está um pouco distante. Enquanto não chega, podemos nos concentrar em outras coisas.

Nos últimos anos, vimos surgir equipamentos que nos ajudam a fazer download e consumir conteúdo. Eles são ótimos e já acharam seu espaço em nossas casas e mochilas.

E há mais por vir, já que todos gostamos de uma boa história. Mas acho que 2012 será um ano no qual nosso desejo para fazer coisas, e não apenas consumir, realmente florescerá.

Seja por meio da cultura dominante do faça você mesmo, com eventos do tipo Make Faire nos Estados Unidos (festival de projetos científicos) ou o aparecimento do steampunk, gênero de ficção científica que reimagina a era vitoriana. Seja [pelas comunidades virtuais] ou com a criação de conteúdo gerado pelos usuários, creio que a possibilidade de se expressar nunca foi tão relevante.

Queremos ser criadores, não consumidores.

O número crescente de laptops, que são mais leves e funcionais, oferecendo a oportunidade para novas experiências e significados, ou o aparecimento de câmeras digitais menores e mais ágeis, com recursos que nos ajudam a tirar a foto que realmente queremos mostram que as tecnologias para criar, compartilhar e aprimorar parecem promissoras em 2012.

Fonte: Inovação Tecnológica

Cérebro de siri

Em 1984, o cineasta James Cameron imaginou um mundo no qual computadores adquiriam inteligência artificial, passando a destruir sistematicamente a humanidade.

O sistema Skynet, de "O Exterminador do Futuro", iria destruir o mundo em 2011.

Sobrevivemos sem nenhum cataclisma a 2011 e o mais próximo que chegamos dos computadores com inteligência artificial foi com o Siri, da Apple.

O Siri não se promove como sendo inteligente, embora prometa ouvir e aprender e, tomara, resolva não nos destruir.

Parece que em 2012 um computador irá passar pelo Teste de Turing, o exame que detecta sistemas inteligentes, deixando-nos mais próximos da inteligência artificial plena.

Ironicamente, a maioria das pessoas não irá se importar com isso.

Máquinas que cuidam

Impressiona a forma como o debate em torno dos objetivos do "computador-humano" se descolou do Teste de Turing e da noção de que uma máquina pareça humana ao estimular o pensamento e a interpretação.

Por ora, queremos mais. Queremos máquinas que cuidem das pessoas e não apenas que pensem como nós. Máquinas que cuidem de nossos interesses.

Há sinais de que tais máquinas já estão no horizonte, o que é bom.

Os equipamentos digitais que nos rodeiam ainda são muito inseguros e requerem garantias constantes. Os atuais sistemas ainda dependem de muita coisa: energia, conectividade, senhas, conteúdos, etc.

Às vezes penso que se nossos equipamentos fossem pessoas, seriam de difícil manutenção. Nos perguntaríamos se não valeria a pena romper com eles.

O problema se torna mais agudo se continuarmos a adquirir mais aparelhos no ritmo atual - e nós continuaremos. Se há um limite para quantos dispositivos e serviços queremos em nossas vidas, não parece que já o tenhamos descoberto.

Máquinas conscientes?

Acho, no entanto, que em 2012 começaremos a ver sinais de mudança em nossa relação com esses equipamentos.

Não falo apenas de novas formas de interface e interação. Há menos sobre reconhecimento de voz e gesto e mais sobre máquinas que são contextualmente conscientes.

E há muita tecnologia séria no trabalho para fazer com que isso aconteça - câmeras que sabem como fazer você aparecer no seu melhor estado, serviços inteligentes que sabem suas preferências e fazem as melhores escolhas para lhe agradar e surpreender.

Creio que estamos vendo nossa interação com os serviços digitais amadurecendo para algo mais próximo a uma relação e menos a algo de trabalho árduo.

Mais do mesmo

Claro, muito disso ainda está um pouco distante. Enquanto não chega, podemos nos concentrar em outras coisas.

Nos últimos anos, vimos surgir equipamentos que nos ajudam a fazer download e consumir conteúdo. Eles são ótimos e já acharam seu espaço em nossas casas e mochilas.

E há mais por vir, já que todos gostamos de uma boa história. Mas acho que 2012 será um ano no qual nosso desejo para fazer coisas, e não apenas consumir, realmente florescerá.

Seja por meio da cultura dominante do faça você mesmo, com eventos do tipo Make Faire nos Estados Unidos (festival de projetos científicos) ou o aparecimento do steampunk, gênero de ficção científica que reimagina a era vitoriana. Seja [pelas comunidades virtuais] ou com a criação de conteúdo gerado pelos usuários, creio que a possibilidade de se expressar nunca foi tão relevante.

Queremos ser criadores, não consumidores.

O número crescente de laptops, que são mais leves e funcionais, oferecendo a oportunidade para novas experiências e significados, ou o aparecimento de câmeras digitais menores e mais ágeis, com recursos que nos ajudam a tirar a foto que realmente queremos mostram que as tecnologias para criar, compartilhar e aprimorar parecem promissoras em 2012.

Fonte: Inovação Tecnológica

quarta-feira, 11 de janeiro de 2012

Aquecimento global pode evitar nova Era Glacial

A última Era Glacial terminou há 11.500 anos, e os cientistas vêm há tempos discutindo quando a próxima começaria.

Aquecimento benéfico?

Cientistas estão afirmando que as emissões de dióxido de carbono (CO2) causadas pela ação do homem irão retardar o início da próxima Era Glacial.

Segundo os estudiosos, os gases causadores do efeito estufa, entre eles o CO2, emitidos pelo ser humano estão na base do fenômeno do aquecimento global.

A última Era Glacial terminou há 11.500 anos, e os cientistas vêm há tempos discutindo quando a próxima começaria.

Os pesquisadores usaram dados da órbita da Terra e outros itens para encontrar o período interglacial mais parecido com o atual.

Em um artigo publicado na revista Nature Geoscience, eles afirmam que a próxima Era Glacial poderia começar em 1.500 anos, mas que isso não acontecerá por causa do elevado nível de emissões de gases de efeito estufa.

"Nos atuais níveis de CO2, mesmo se as emissões parassem agora teríamos provavelmente uma longa duração interglacial determinada por quaisquer processos de longo prazo que poderiam começar para reduzir o CO2 atmosférico", afirma o coordenador da pesquisa, Luke Skinner, da Universidade de Cambridge.

O grupo de Skinner, que também inclui cientistas da Universidade College de Londres, da Universidade da Flórida e da Universidade de Bergen, na Noruega, calcula que a concentração atmosférica de CO2 deveria cair para menos de 240 partes por milhão (ppm) para que a glaciação pudesse começar.

O atual nível de CO2 é de cerca de 390 ppm, e outros grupos de pesquisadores já mostraram que, mesmo se as emissões parassem instantaneamente, as concentrações se manteriam elevadas por pelo menos mil anos, o suficiente para que o calor armazenado nos oceanos provocasse potencialmente um significativo derretimento do gelo polar e o aumento do nível do mar.

Ciclos de Milankovitch

A causa básica das transições entre as Eras Glaciais e os períodos interglaciais são as variações sutis na órbita terrestre, conhecidas como ciclos de Milankovitch, descritas pelo cientista sérvio Milutin Milankovitch há quase um século.

Essas variações ocorrem em períodos de dezenas de milhares de anos.

A maneira precisa como elas mudam o clima da Terra entre os períodos interglaciais, mais quentes, e as Eras Glaciais, a cada 100 mil anos mais ou menos, não é conhecida.

Por si só, as variações não são capazes de levar a uma diferença de temperaturas de cerca de 10 graus Celsius entre a Era Glacial e o período interglacial.

As pequenas variações iniciais são amplificadas por vários fatores, incluindo o lançamento de dióxido de carbono na atmosfera, quando o aquecimento começa, e a absorção do gás pelos oceanos, quando o gelo se forma novamente.

Também está claro que cada transição é diferente das anteriores porque a combinação precisa de fatores orbitais não se repete exatamente - apesar de condições muito semelhantes acontecerem a cada 400 mil anos.

As diferenças de um ciclo para o seguinte seriam a razão de os períodos interglaciais não terem sempre a mesma duração.

Grupos que se opõem à limitação das emissões de gases de efeito estufa dizem que elas podem evitar nova Era Glacial.

Transição para Era Glacial

Usando análises de dados da órbita terrestre, além de amostras de rochas retiradas do fundo do oceano, a equipe de Skinner identificou um episódio chamado Estágio Marinho Isótopo 19c (ou MIS19c), há 780 mil anos, que se parece muito com o presente.

Segundo eles, a transição para a Era Glacial foi sinalizada por um período quando o esfriamento e o aquecimento se revezaram entre os hemisférios norte e sul, provocados por interrupções na circulação global de correntes oceânicas.

Se a analogia ao MIS19c for correta, essa transição deveria começar em 1.500 anos, segundo os pesquisadores, se as concentrações de CO2 estivessem em níveis "naturais".

As conclusões mais amplas dos pesquisadores foram endossadas por Lawrence Mysak, professor-emérito de ciências atmosféricas e oceânicas na Universidade McGill, em Montreal, no Canadá, que também investigou as transições entre as Eras Glaciais e os períodos interglaciais.

"A questão-chave é que eles estão olhando para 800 mil anos atrás, o que é duas vezes o ciclo de 400 mil anos, então eles estão olhando para o período correto em termos do que poderia ocorrer sobre a ausência de forças antropogênicas", disse ele à BBC.

Mas ele sugeriu que o nível de 240 ppm de CO2 para provocar a próxima glaciação poderia ser muito baixo. Outros estudos sugeriram que esse nível poderia ser 20 ou até 30 ppm mais alto.

"Mas em todo caso, o problema é como chegamos a 240, 250 ou o que quer que seja? A absorção pelos oceanos leva milhares ou dezenas de milhares de anos, então não acho que seja realista pensar que veremos a próxima glaciação na escala natural", explicou Mysak.

Briga política

Grupos que se opõem à limitação das emissões de gases do efeito estufa já citam o estudo como uma razão para apoiar a manutenção das emissões humanas de CO2.

O grupo britânico Global Warming Policy Foundation, por exemplo, cita um ensaio de 1999 dos astrônomos Fred Hoyle e Chandra Wickramasinghe, que argumentavam: "A volta das condições da Era Glacial deixaria grandes frações das maiores áreas produtoras de alimentos do mundo inoperantes, e levaria inevitavelmente à extinção da maioria da população humana presente".

"Precisamos buscar um efeito estufa sustentado para manter o presente clima mundial vantajoso. Isso implica a habilidade de injetar efetivamente gases do efeito estufa na atmosfera, o oposto do que os ambientalistas estão erroneamente defendendo", dizem.

Luke Skinner e sua equipe já antecipavam esse tipo de reação.

"É uma discussão filosófica interessante. Poderíamos estar melhor em um mundo mais quente do que em uma glaciação? Provavelmente sim," observa ele.

"Mas estaríamos perdendo o ponto central da discussão, porque a direção em que estamos indo não é manter nosso clima quente atual, mas um aquecimento ainda maior, e adicionar CO2 a um clima quente é muito diferente de adicionar a um clima frio", diz.

"O ritmo de mudança com o CO2 é basicamente sem precedentes, e há enormes consequências se não pudemos lidar com isso", afirma.

Fonte: Inovação Tecnológica

Aquecimento benéfico?

Cientistas estão afirmando que as emissões de dióxido de carbono (CO2) causadas pela ação do homem irão retardar o início da próxima Era Glacial.

Segundo os estudiosos, os gases causadores do efeito estufa, entre eles o CO2, emitidos pelo ser humano estão na base do fenômeno do aquecimento global.

A última Era Glacial terminou há 11.500 anos, e os cientistas vêm há tempos discutindo quando a próxima começaria.

Os pesquisadores usaram dados da órbita da Terra e outros itens para encontrar o período interglacial mais parecido com o atual.

Em um artigo publicado na revista Nature Geoscience, eles afirmam que a próxima Era Glacial poderia começar em 1.500 anos, mas que isso não acontecerá por causa do elevado nível de emissões de gases de efeito estufa.

"Nos atuais níveis de CO2, mesmo se as emissões parassem agora teríamos provavelmente uma longa duração interglacial determinada por quaisquer processos de longo prazo que poderiam começar para reduzir o CO2 atmosférico", afirma o coordenador da pesquisa, Luke Skinner, da Universidade de Cambridge.

O grupo de Skinner, que também inclui cientistas da Universidade College de Londres, da Universidade da Flórida e da Universidade de Bergen, na Noruega, calcula que a concentração atmosférica de CO2 deveria cair para menos de 240 partes por milhão (ppm) para que a glaciação pudesse começar.

O atual nível de CO2 é de cerca de 390 ppm, e outros grupos de pesquisadores já mostraram que, mesmo se as emissões parassem instantaneamente, as concentrações se manteriam elevadas por pelo menos mil anos, o suficiente para que o calor armazenado nos oceanos provocasse potencialmente um significativo derretimento do gelo polar e o aumento do nível do mar.

Ciclos de Milankovitch

A causa básica das transições entre as Eras Glaciais e os períodos interglaciais são as variações sutis na órbita terrestre, conhecidas como ciclos de Milankovitch, descritas pelo cientista sérvio Milutin Milankovitch há quase um século.

Essas variações ocorrem em períodos de dezenas de milhares de anos.

A maneira precisa como elas mudam o clima da Terra entre os períodos interglaciais, mais quentes, e as Eras Glaciais, a cada 100 mil anos mais ou menos, não é conhecida.

Por si só, as variações não são capazes de levar a uma diferença de temperaturas de cerca de 10 graus Celsius entre a Era Glacial e o período interglacial.

As pequenas variações iniciais são amplificadas por vários fatores, incluindo o lançamento de dióxido de carbono na atmosfera, quando o aquecimento começa, e a absorção do gás pelos oceanos, quando o gelo se forma novamente.

Também está claro que cada transição é diferente das anteriores porque a combinação precisa de fatores orbitais não se repete exatamente - apesar de condições muito semelhantes acontecerem a cada 400 mil anos.

As diferenças de um ciclo para o seguinte seriam a razão de os períodos interglaciais não terem sempre a mesma duração.

Grupos que se opõem à limitação das emissões de gases de efeito estufa dizem que elas podem evitar nova Era Glacial.

Transição para Era Glacial

Usando análises de dados da órbita terrestre, além de amostras de rochas retiradas do fundo do oceano, a equipe de Skinner identificou um episódio chamado Estágio Marinho Isótopo 19c (ou MIS19c), há 780 mil anos, que se parece muito com o presente.

Segundo eles, a transição para a Era Glacial foi sinalizada por um período quando o esfriamento e o aquecimento se revezaram entre os hemisférios norte e sul, provocados por interrupções na circulação global de correntes oceânicas.

Se a analogia ao MIS19c for correta, essa transição deveria começar em 1.500 anos, segundo os pesquisadores, se as concentrações de CO2 estivessem em níveis "naturais".

As conclusões mais amplas dos pesquisadores foram endossadas por Lawrence Mysak, professor-emérito de ciências atmosféricas e oceânicas na Universidade McGill, em Montreal, no Canadá, que também investigou as transições entre as Eras Glaciais e os períodos interglaciais.

"A questão-chave é que eles estão olhando para 800 mil anos atrás, o que é duas vezes o ciclo de 400 mil anos, então eles estão olhando para o período correto em termos do que poderia ocorrer sobre a ausência de forças antropogênicas", disse ele à BBC.

Mas ele sugeriu que o nível de 240 ppm de CO2 para provocar a próxima glaciação poderia ser muito baixo. Outros estudos sugeriram que esse nível poderia ser 20 ou até 30 ppm mais alto.

"Mas em todo caso, o problema é como chegamos a 240, 250 ou o que quer que seja? A absorção pelos oceanos leva milhares ou dezenas de milhares de anos, então não acho que seja realista pensar que veremos a próxima glaciação na escala natural", explicou Mysak.

Briga política

Grupos que se opõem à limitação das emissões de gases do efeito estufa já citam o estudo como uma razão para apoiar a manutenção das emissões humanas de CO2.

O grupo britânico Global Warming Policy Foundation, por exemplo, cita um ensaio de 1999 dos astrônomos Fred Hoyle e Chandra Wickramasinghe, que argumentavam: "A volta das condições da Era Glacial deixaria grandes frações das maiores áreas produtoras de alimentos do mundo inoperantes, e levaria inevitavelmente à extinção da maioria da população humana presente".

"Precisamos buscar um efeito estufa sustentado para manter o presente clima mundial vantajoso. Isso implica a habilidade de injetar efetivamente gases do efeito estufa na atmosfera, o oposto do que os ambientalistas estão erroneamente defendendo", dizem.

Luke Skinner e sua equipe já antecipavam esse tipo de reação.

"É uma discussão filosófica interessante. Poderíamos estar melhor em um mundo mais quente do que em uma glaciação? Provavelmente sim," observa ele.

"Mas estaríamos perdendo o ponto central da discussão, porque a direção em que estamos indo não é manter nosso clima quente atual, mas um aquecimento ainda maior, e adicionar CO2 a um clima quente é muito diferente de adicionar a um clima frio", diz.

"O ritmo de mudança com o CO2 é basicamente sem precedentes, e há enormes consequências se não pudemos lidar com isso", afirma.

Fonte: Inovação Tecnológica

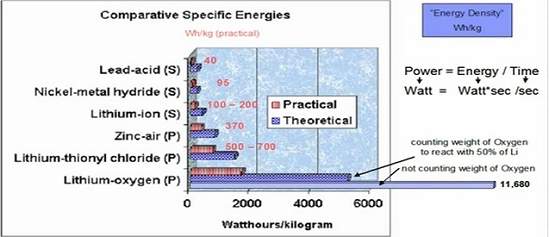

Bateria de ar-lítio: carros elétricos com autonomia de 800 km

Ansiedade de motorista

A bateria de ar-lítio está funcionando em escala de laboratório, e os cientistas prometem um protótipo em escala real para o próximo ano.

Um dos maiores entraves à popularização dos veículos elétricos é a chamada "ansiedade da autonomia".

Os motoristas parecem morrer de medo de que a carga da bateria não consiga levá-los até seu destino ou trazê-los de volta para casa.

Agora, cientistas da IBM afirmam ter resolvido um problema fundamental que poderá levar à criação de uma bateria capaz de dar a um carro elétrico uma autonomia de 800 quilômetros - o dobro da autonomia da maioria dos carros a gasolina ou etanol.

As melhores baterias disponíveis atualmente são do tipo íons de lítio, que são boas para telefones celulares, razoavelmente boas para notebooks, mas insuficientes para veículos elétricos, que não conseguem superar os 200 km de autonomia.

Bateria de ar-lítio

Um novo tipo de bateria, chamada bateria de ar-lítio, é muito mais interessante porque sua densidade teórica de energia é 1.000 vezes maior do que as baterias de íons de lítio, o que a coloca praticamente em condições de igualdade com a gasolina.

Em vez de usar óxidos metálicos no eletrodo positivo, as baterias de ar-lítio usam carbono, que é mais leve e mais barato, e reage com o oxigênio do ar ambiente para produzir uma corrente elétrica.

Mas há um problema: as instabilidades químicas limitam a vida útil das baterias de ar-lítio, que suportam poucos ciclos de carga e descarga - algo impraticável para os veículos elétricos.

Agora, Winfried Wilcke e seus colegas dos laboratórios da IBM descobriram a causa dessa rápida degradação: o oxigênio do ar reage não apenas com o eletrodo de carbono, mas também com o eletrólito, a solução condutora que transporta os íons de lítio entre os eletrodos.

A bateria ar-lítio tem um potencial teórico mais de 1.000 vezes superior às baterias mais modernas.

Essa reação indesejada deteriora o eletrólito, danificando a bateria.

Eletrólito promissor

Os pesquisadores usaram então um supercomputador para modelar essas reações químicas, em busca de eletrólitos alternativos, que não fossem danificados pela reação com o oxigênio.

"Nós agora descobrimos um [novo eletrólito] que parece muito promissor," contou Wilcke.

A pesquisa ainda não foi publicada, e os pesquisadores se recusam a dar mais detalhes sobre o novo composto, embora contem que o material funcionou como previsto nos modelos computadorizados "em vários protótipos em escala de laboratório".

Segundo Wilcke, a expectativa é que um protótipo em escala real esteja pronto até 2013.

Mas ainda há um grande desafio antes que as baterias de ar-lítio possam cumprir todas as suas promessas: como lidar com a umidade do ar ambiente, já que o lítio pega fogo espontaneamente quando imerso em água.

Fonte: Inovação Tecnológica

A bateria de ar-lítio está funcionando em escala de laboratório, e os cientistas prometem um protótipo em escala real para o próximo ano.

Um dos maiores entraves à popularização dos veículos elétricos é a chamada "ansiedade da autonomia".

Os motoristas parecem morrer de medo de que a carga da bateria não consiga levá-los até seu destino ou trazê-los de volta para casa.

Agora, cientistas da IBM afirmam ter resolvido um problema fundamental que poderá levar à criação de uma bateria capaz de dar a um carro elétrico uma autonomia de 800 quilômetros - o dobro da autonomia da maioria dos carros a gasolina ou etanol.

As melhores baterias disponíveis atualmente são do tipo íons de lítio, que são boas para telefones celulares, razoavelmente boas para notebooks, mas insuficientes para veículos elétricos, que não conseguem superar os 200 km de autonomia.

Bateria de ar-lítio

Um novo tipo de bateria, chamada bateria de ar-lítio, é muito mais interessante porque sua densidade teórica de energia é 1.000 vezes maior do que as baterias de íons de lítio, o que a coloca praticamente em condições de igualdade com a gasolina.

Em vez de usar óxidos metálicos no eletrodo positivo, as baterias de ar-lítio usam carbono, que é mais leve e mais barato, e reage com o oxigênio do ar ambiente para produzir uma corrente elétrica.

Mas há um problema: as instabilidades químicas limitam a vida útil das baterias de ar-lítio, que suportam poucos ciclos de carga e descarga - algo impraticável para os veículos elétricos.

Agora, Winfried Wilcke e seus colegas dos laboratórios da IBM descobriram a causa dessa rápida degradação: o oxigênio do ar reage não apenas com o eletrodo de carbono, mas também com o eletrólito, a solução condutora que transporta os íons de lítio entre os eletrodos.

A bateria ar-lítio tem um potencial teórico mais de 1.000 vezes superior às baterias mais modernas.

Essa reação indesejada deteriora o eletrólito, danificando a bateria.

Eletrólito promissor

Os pesquisadores usaram então um supercomputador para modelar essas reações químicas, em busca de eletrólitos alternativos, que não fossem danificados pela reação com o oxigênio.

"Nós agora descobrimos um [novo eletrólito] que parece muito promissor," contou Wilcke.

A pesquisa ainda não foi publicada, e os pesquisadores se recusam a dar mais detalhes sobre o novo composto, embora contem que o material funcionou como previsto nos modelos computadorizados "em vários protótipos em escala de laboratório".

Segundo Wilcke, a expectativa é que um protótipo em escala real esteja pronto até 2013.

Mas ainda há um grande desafio antes que as baterias de ar-lítio possam cumprir todas as suas promessas: como lidar com a umidade do ar ambiente, já que o lítio pega fogo espontaneamente quando imerso em água.

Fonte: Inovação Tecnológica

domingo, 8 de janeiro de 2012

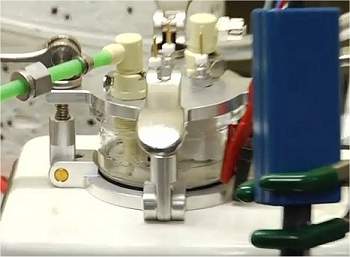

Motor rotativo não-magnético ultrapreciso

O pequeno motor, que não produz interferências, deverá ter aplicações imediatas em equipamentos médicos e hospitalares, incluindo robôs cirurgiões.

Motor não-magnético

Engenheiros dinamarqueses criaram um motor elétrico que gira sem usar o magnetismo e sem precisar de engrenagens.

O pequeno motor, de alto desempenho, deverá ter aplicações imediatas em todos os equipamentos onde é importante eliminar as interferências eletromagnéticas.

Isto é essencial em equipamentos médicos e hospitalares, como bombas de infusão, equipamentos de ressonância magnética e tomografia computadorizada, robôs cirurgiões e vários outros.

De linear para rotativo

O motor usa a tecnologia piezoelétrica, já explorada em alguns músculos artificiais, graças à capacidade de determinados materiais de se expandirem quando recebem uma corrente elétrica - o inverso também é verdadeiro, eles geram eletricidade quando recebem um tranco.

A grande inovação do novo motor foi transformar o movimento linear de fios piezoelétricos - que se esticam quando recebem energia - em um movimento rotativo, criando um motor rotativo não magnético.

Segundo os engenheiros da Universidade Técnica da Dinamarca, o motor tem uma rotação estável graças a um sistema de controle na transferência do movimento linear para movimento rotativo.

Como não exige engrenagens, o motor é simples e fácil de integrar em outros equipamentos.

Exames e robôs cirurgiões

O Dr. Michael Andersen destaca que o novo motor não-magnético permitirá a construção de equipamentos de tomografia e ressonância à prova de interferências eletromagnéticas, possibilitando a instalação e a operação conjunta de vários desses equipamentos.

Já o pesquisador Mogens Arentoft ressalta a importância dos novos motores para o desenvolvimento de uma nova geração de robôs cirurgiões: "Há muitos sistemas onde esta tecnologia significará novas aplicações. Seu uso na tecnologia robótica será automático."

Segundo o pesquisador, "a rotação do motor pode ser controlada tão precisamente que seu uso em robôs para cirurgias, biópsias e outros procedimentos será natural."

Fonte: Inovação Tecnológica

Motor não-magnético

Engenheiros dinamarqueses criaram um motor elétrico que gira sem usar o magnetismo e sem precisar de engrenagens.

O pequeno motor, de alto desempenho, deverá ter aplicações imediatas em todos os equipamentos onde é importante eliminar as interferências eletromagnéticas.

Isto é essencial em equipamentos médicos e hospitalares, como bombas de infusão, equipamentos de ressonância magnética e tomografia computadorizada, robôs cirurgiões e vários outros.

De linear para rotativo

O motor usa a tecnologia piezoelétrica, já explorada em alguns músculos artificiais, graças à capacidade de determinados materiais de se expandirem quando recebem uma corrente elétrica - o inverso também é verdadeiro, eles geram eletricidade quando recebem um tranco.

A grande inovação do novo motor foi transformar o movimento linear de fios piezoelétricos - que se esticam quando recebem energia - em um movimento rotativo, criando um motor rotativo não magnético.

Segundo os engenheiros da Universidade Técnica da Dinamarca, o motor tem uma rotação estável graças a um sistema de controle na transferência do movimento linear para movimento rotativo.

Como não exige engrenagens, o motor é simples e fácil de integrar em outros equipamentos.

Exames e robôs cirurgiões

O Dr. Michael Andersen destaca que o novo motor não-magnético permitirá a construção de equipamentos de tomografia e ressonância à prova de interferências eletromagnéticas, possibilitando a instalação e a operação conjunta de vários desses equipamentos.

Já o pesquisador Mogens Arentoft ressalta a importância dos novos motores para o desenvolvimento de uma nova geração de robôs cirurgiões: "Há muitos sistemas onde esta tecnologia significará novas aplicações. Seu uso na tecnologia robótica será automático."

Segundo o pesquisador, "a rotação do motor pode ser controlada tão precisamente que seu uso em robôs para cirurgias, biópsias e outros procedimentos será natural."

Fonte: Inovação Tecnológica

quarta-feira, 4 de janeiro de 2012

Tempo mundial pode mudar em 2012

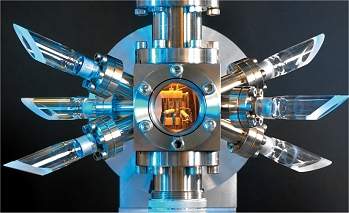

Uma nova forma de marcar o tempo? Esta armadilha de átomos de estrôncio, parte principal de um relógio atômico, poderá mudar a forma como o mundo mede o tempo.

Segundo bissexto

O tempo, tal como o conhecemos hoje, poderá não ser exatamente o mesmo tempo nos séculos que virão.

Tanto que os cientistas da área estão usando todo o seu tempo durante as festas de fim de ano para discutir uma nova definição da escala de tempo do mundo: o chamado Tempo Universal Coordenado (UTC).

E a principal questão em debate é o segundo bissexto - mais especificamente, a abolição do segundo bissexto.

Tempo tecnológico

Enquanto todo o mundo presta atenção aos anos bissextos, poucos sabem que uma "ajeitada" muito mais frequente no tempo, mas muito mais irregular, é feita constantemente.

Uma mudança que é essencial para manter o bom funcionamento dos sistemas de GPS, das telecomunicações, e até dos arquivos que você transfere pela internet.

O segundo bissexto surgiu no início da atual era tecnológica, em 1972. Ele é adicionado para manter a escala de tempo medida pelos relógios atômicos em fase com a escala de tempo baseada na rotação da Terra.

A razão para isto é que, enquanto os relógios atômicos, que usam as vibrações dos átomos para contar os segundos, são incrivelmente precisos, a Terra não é um cronometrista tão confiável quanto se acreditava - isto graças a uma ligeira oscilação que ela sofre conforme gira sobre seu próprio eixo:

Rotação da Terra é medida diretamente pela primeira vez

"Desde a década de 1920 já se sabe que o movimento da Terra não é tão constante como tínhamos pensado inicialmente," explica Rory McEvoy, curador de "horologia" do observatório de Greenwich, no Reino Unido.

Essa variação natural da Terra significa que as horas medidas pelos relógios atômicos e as horas baseadas na rotação da Terra ficam cada vez mais defasadas conforme o tempo passa.

Assim, a cada poucos anos, antes que essa diferença cresça mais do que 0,9 segundo, um segundo extra - o chamado segundo bissexto - é adicionado ao tempo oficial, para colocar novamente os dois em sincronia.

"O Serviço Internacional de Rotação da Terra monitora a atividade da Terra, e eles decidem quando é apropriado adicionar um segundo bissexto em nossa escala de tempo," explica McEvoy.

Guerra do segundo

Um dos maiores problemas é que, ao contrário dos anos bissextos, os segundos bissextos não são previsíveis. Eles são erráticos, porque as oscilações da Terra - o chamado balanço de Chandler - não é regular.

Mas a tentativa de se livrar do segundo bissexto está causando um racha dentro da comunidade internacional que estuda o tempo, o que deverá ser decidido pelo voto, durante a Conferência Mundial de Radiocomunicações, da União Internacional das Telecomunicações (UIT), em janeiro de 2012, em Genebra.

Uma pesquisa informal feita pela UIT no início deste ano revelou que três países - Reino Unido, China e Canadá - são fortemente contra a alteração do sistema atual.

No entanto, 13 países, incluindo os Estados Unidos, França, Itália e Alemanha, querem uma nova escala de tempo que não tenha segundos bissextos.

Mas, com quase 200 países membros, a grande maioria deles ainda terá que revelar o que realmente pensa sobre o tempo.

O Bureau Internacional de Pesos e Medidas (BIPM), em Paris, é a organização internacional de padronização que é responsável por manter o tempo do mundo.

A organização acredita que o segundo bissexto deve acabar porque esses ajustes estão se tornando cada vez mais problemáticos para sistemas que precisam de uma referência estável e contínua de tempo.

"Ele está afetando as telecomunicações, é problemático para a transferência de dados pela internet (como o Network Time Protocol, ou NTP), bem como dos serviços financeiros," diz o Dr. Arias Felicitas, diretor do BIPM.

"Outra aplicação que está sendo realmente muito, muito afetada pelo segundo bissexto, é a sincronização de tempo nos Sistemas Globais de Navegação por Satélite (GNSS). Os GNSS exigem uma sincronização de tempo perfeita - e segundos bissextos são um incômodo," completa Felicitas.

Tempos divergentes

Mas desacoplar o tempo civil da rotação da Terra também pode ter consequências a longo prazo.

"[Se você eliminar os segundos bissextos] o UTC irá se afastar continuamente do tempo baseado na rotação da Terra, fazendo-os gradualmente divergirem por uma quantidade crescente de tempo. Algo terá que ser feito para corrigir essa divergência cada vez maior," explica Peter Whibberley, cientista do Laboratório Nacional de Física do Reino Unido.

Em algumas décadas, isso equivaleria a um minuto de diferença. E, ao longo de centenas de anos, isso significaria uma diferença de uma hora entre o tempo dos relógios atômicos e a escala de tempo baseada na rotação da Terra.

Em 2004, foi proposta a ideia da troca dos segundos bissextos por um salto de uma hora, a ser feita uma vez a cada alguns poucos séculos.

Uma possível solução, se o segundo bissexto for abolido, seria atrelar essa "hora bissexta" às mudanças no horário de verão.

"Os países poderiam simplesmente acomodar a divergência não adiantando os seus relógios na primavera, apenas uma vez a cada poucos séculos, assim você altera o fuso horário em uma hora para trazer de volta tempo civil em conformidade com a rotação da Terra," propõe o Dr. Whibberley.

Fonte: Inovação Tecnológica

Segundo bissexto

O tempo, tal como o conhecemos hoje, poderá não ser exatamente o mesmo tempo nos séculos que virão.

Tanto que os cientistas da área estão usando todo o seu tempo durante as festas de fim de ano para discutir uma nova definição da escala de tempo do mundo: o chamado Tempo Universal Coordenado (UTC).

E a principal questão em debate é o segundo bissexto - mais especificamente, a abolição do segundo bissexto.

Tempo tecnológico

Enquanto todo o mundo presta atenção aos anos bissextos, poucos sabem que uma "ajeitada" muito mais frequente no tempo, mas muito mais irregular, é feita constantemente.

Uma mudança que é essencial para manter o bom funcionamento dos sistemas de GPS, das telecomunicações, e até dos arquivos que você transfere pela internet.

O segundo bissexto surgiu no início da atual era tecnológica, em 1972. Ele é adicionado para manter a escala de tempo medida pelos relógios atômicos em fase com a escala de tempo baseada na rotação da Terra.

A razão para isto é que, enquanto os relógios atômicos, que usam as vibrações dos átomos para contar os segundos, são incrivelmente precisos, a Terra não é um cronometrista tão confiável quanto se acreditava - isto graças a uma ligeira oscilação que ela sofre conforme gira sobre seu próprio eixo:

Rotação da Terra é medida diretamente pela primeira vez

"Desde a década de 1920 já se sabe que o movimento da Terra não é tão constante como tínhamos pensado inicialmente," explica Rory McEvoy, curador de "horologia" do observatório de Greenwich, no Reino Unido.

Essa variação natural da Terra significa que as horas medidas pelos relógios atômicos e as horas baseadas na rotação da Terra ficam cada vez mais defasadas conforme o tempo passa.

Assim, a cada poucos anos, antes que essa diferença cresça mais do que 0,9 segundo, um segundo extra - o chamado segundo bissexto - é adicionado ao tempo oficial, para colocar novamente os dois em sincronia.

"O Serviço Internacional de Rotação da Terra monitora a atividade da Terra, e eles decidem quando é apropriado adicionar um segundo bissexto em nossa escala de tempo," explica McEvoy.

Guerra do segundo

Um dos maiores problemas é que, ao contrário dos anos bissextos, os segundos bissextos não são previsíveis. Eles são erráticos, porque as oscilações da Terra - o chamado balanço de Chandler - não é regular.

Mas a tentativa de se livrar do segundo bissexto está causando um racha dentro da comunidade internacional que estuda o tempo, o que deverá ser decidido pelo voto, durante a Conferência Mundial de Radiocomunicações, da União Internacional das Telecomunicações (UIT), em janeiro de 2012, em Genebra.

Uma pesquisa informal feita pela UIT no início deste ano revelou que três países - Reino Unido, China e Canadá - são fortemente contra a alteração do sistema atual.

No entanto, 13 países, incluindo os Estados Unidos, França, Itália e Alemanha, querem uma nova escala de tempo que não tenha segundos bissextos.

Mas, com quase 200 países membros, a grande maioria deles ainda terá que revelar o que realmente pensa sobre o tempo.

O Bureau Internacional de Pesos e Medidas (BIPM), em Paris, é a organização internacional de padronização que é responsável por manter o tempo do mundo.

A organização acredita que o segundo bissexto deve acabar porque esses ajustes estão se tornando cada vez mais problemáticos para sistemas que precisam de uma referência estável e contínua de tempo.

"Ele está afetando as telecomunicações, é problemático para a transferência de dados pela internet (como o Network Time Protocol, ou NTP), bem como dos serviços financeiros," diz o Dr. Arias Felicitas, diretor do BIPM.