Ímã Artificial

Magnetismo é um ramo da ciência que estuda os materiais magnéticos, que possuem a capacidade de atrair ou repelir outros materiais. Quando se fala em magnetismo o primeiro nome que vem à tona é o de Tales de Mileto, pois foi ele o primeiro a estudar a capacidade que uma substância tem de atrair outra, isso sem que exista contato entre elas. Contudo, na Antigüidade os chineses já possuíam o conhecimento de alguns materiais que podiam atrair outros. Eles utilizavam esses materiais em bússolas para se orientar quando estavam se deslocando em missões militares, pois a bússola se orientava no sentido do eixo terrestre, ou seja, o norte-sul magnético que se localiza bem próximo do norte-sul geográfico da Terra.

O fenômeno do magnetismo não despertou muitos interesses até o século XIII. Foi somente após esse período que surgiram cientistas interessados em saber e explicar o fenômeno do magnetismo. Contudo, foi somente no século XIX que Oersted deu início ao estudo sobre eletromagnetismo e Maxwell completou o estudo sobre o eletromagnetismo ao elaborar as leis que regem esse fenômeno.

Hoje, após as descobertas de Maxwell e as várias outras contribuições que o ramo do eletromagnetismo teve, é impossível estudar eletricidade e magnetismo de maneira separada. O magnetismo se encontra muito presente, são utilizados em motores, dínamos, transformadores, bobinas, ou seja, nos equipamentos elétricos em geral.

O magnetismo pode ser explicado através da movimentação dos elétrons, e para determinar se um determinado material é magnético ou não, basta colocá-lo sobre a influência de um campo magnético, que é gerado pelo movimento de cargas elétricas. O material será magnético se aparecer forças ou torques, podendo dessa forma ser chamada de substância magnética.

A Lei de Lenz

Após diversos testes realizados experimentalmente, Faraday conseguiu chegar a uma conclusão com exatidão a respeito da corrente induzida: quando o número das linhas de campo que atravessam um circuito varia, nesse circuito aparece uma corrente elétrica denominada corrente induzida.

Definida a condição para que exista a corrente induzida, falta ainda explicar como obter o sentido dessa corrente. Quem elaborou a explicação mais simples para isso foi o físico Heinrich Friedrich Lenz. Segundo ele:

O sentido da corrente induzida é tal que o campo magnético por ela produzido se opõe à mudança de fluxo que se originou.

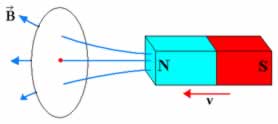

Figura 1: O campo magnético criado pelo ímã cria um fluxo magnético no interior da espira

Como mostra a figura 1 acima, o campo magnético criado pelo ímã se aproxima da espira, de modo que o fluxo magnético no seu interior também aumenta. Segundo a Lei proposta por Lenz, a corrente induzida se opõe ao aumento de fluxo magnético. Para que tal fato aconteça, a corrente induzida na espira deve criar um campo magnético de modo que o fluxo de () através da espira tenha valor contrário ao do fluxo . Em consequência disso, deduzimos que deve ter sentido oposto ao de , como mostra a figura 2. Se aplicarmos a regra da mão direita veremos que a corrente induzida possui o sentido indicado na figura 2.

Figura 2: Corrente induzida criada pelo campo magnético do ímã

Fonte: Mundoeducação

Pesquisar

sexta-feira, 30 de dezembro de 2011

segunda-feira, 26 de dezembro de 2011

Circuitos elétricos se autoconsertam com metal líquido

Auto-reparo elétrico

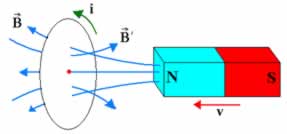

Engenheiros da Universidade de Illinois, nos Estados Unidos, desenvolveram um mecanismo que permite que circuitos elétricos ou eletrônicos consertem fisicamente a si mesmos em caso de falha.

Os circuitos integrados, e os fios que os conectam, estão cada vez menores.

Não apenas o tempo, mas também a fadiga térmica, que leva a sucessivas ondas de expansão-contração, faz com que essas conexões metálicas trinquem, inutilizando todo o circuito e, muitas vezes, o equipamento inteiro.

"Em vez de ter que fabricar circuitos redundantes, ou construir um sistema de diagnóstico, este material foi projetado para cuidar sozinho do problema," diz o professor Jeffrey Moore, um dos idealizadores do sistema de autoconserto.

Restaurando a condutividade

A equipe havia anteriormente desenvolvido um sistema de autocicatrização que imita a pele humana, mas que funciona apenas para polímeros.

Agora eles conseguiram expandir a técnica para materiais condutores.

Os pesquisadores dispersaram cápsulas com tamanho médio de 10 micrômetros sobre os fios de um circuito eletrônico, que foi sendo gradativamente puxado, forçando a criação de uma trinca.

Conforme a trinca se propaga, as microcápsulas se quebram e liberam o metal líquido (uma solução com nanopartículas de índio e gálio) contido em seu interior. O metal preenche a fissura no circuito, restaurando a condutividade elétrica.

Esse conceito, de microcápsulas que se rompem, já é largamente utilizado em materiais autocicatrizantes, inclusive em metais que se curam sozinhos de arranhões, mas sempre com objetivos estruturais - o objetivo aqui é a restauração da condutividade.

A quebra do fio interrompeu o circuito por apenas alguns microssegundos, enquanto o metal líquido preenchia a falha.

Nos experimentos, 90% das amostras recuperaram 99% de sua capacidade de condução elétrica.

Aplicações elétricas

Embora os pesquisadores se refiram a aplicações de sua técnica em circuitos eletrônicos, as cápsulas são grandes demais para os circuitos integrados, cujos transistores e suas interconexões têm dimensões na escala dos nanômetros - 1.000 vezes menores do que as cápsulas usadas.

Mas o enfoque é interessante para circuitos elétricos propriamente ditos, como fiações em satélites artificiais, naves e sondas espaciais, aviões, ou mesmo em automóveis, onde uma interrupção pode ser catastrófica ou cara demais para ser consertada.

Os eletrodos de baterias são outro campo natural de aplicação da nova tecnologia.

Fonte: Inovação Tecnológica

Nasa encontra dois planetas com o tamanho da Terra

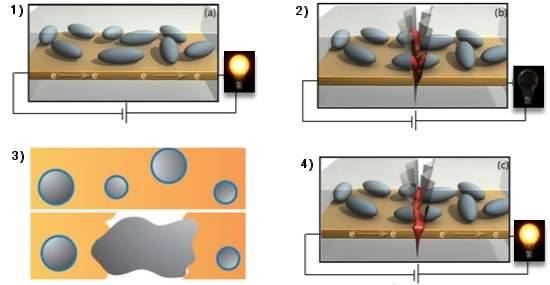

Os astrônomos da missão Kepler da Nasa anunciaram nesta terça-feira a descoberta de dois planetas do tamanho da Terra que orbitam em torno de uma estrela distante, e classificaram a descoberta como "um marco na busca de mundos extraterrestres".

Os dois planetas, batizados de "Kepler-20e" e "Kepler-20f", são os primeiros de tamanho parecido ao da Terra orbitando uma estrela fora de nosso Sistema Solar. Um deles tem diâmetro 3% menor que o da Terra, enquanto o outro é 3% maior.

"Após quase três anos, o observatório orbital Kepler confirmou a existência de planetas que orbitam estrelas", disse em teleconferência Nick Gautier, do Laboratório de Propulsão da Nasa em Pasadena, estado americano da Califórnia.

Dado que os dois planetas orbitam muito perto da estrela, os pesquisadores acham que, devido às altas temperaturas, não são capazes de sustentar vida. No entanto, a descoberta aproxima os cientistas a sua meta de achar um planeta similar à Terra e que seja habitável.

Ambos os planetas orbitam a estrela Kepler-20, um astro classificado como tipo G, levemente mais frio que o Sol e situado a quase mil anos-luz da Terra. Os pesquisadores acreditam que esses planetas têm composição rochosa, de modo que suas massas devem ser entre 2,7 menos e 3 vezes maiores que a massa da Terra.

O "Kepler-20f" completa sua órbita a cada 19,6 dias, a uma distância de 16,6 milhões de quilômetros. Estas órbitas tão reduzidas provocam temperaturas planetárias entre 760 e 430 graus Celsius, o que torna quase impossível a existência de água líquida nos planetas.

Já o "Kepler-20e" orbita sua estrela a cada 6,1 dias, a uma distância de 7,6 milhões de quilômetros, isto é, quase 20 vezes mais perto de seu astro que a Terra, que orbita o Sol a cerca de 150 milhões de quilômetros.

"Cruzamos um limite: pela primeira vez, detectamos planetas menores que a Terra em torno de outra estrela", disse o cientista François Fressin, do Centro Harvard Smithsonian para Astrofísica em Cambridge, estado americano de Massachusetts. "Provamos que existem planetas como a Terra em torno de outras estrelas e, mais importante ainda, provamos que a humanidade pode detectá-los", afirmou. "É o começo de uma era".

Os pesquisadores já identificaram mais de 700 planetas fora do Sistema Solar. Desde seu lançamento em março de 2009, o telescópio Kepler localizou 2.326 possíveis planetas e confirmou a existência de 28.

"Durante as últimas duas décadas, ficou claro que, no final, os astrônomos atingiriam esta meta, mas também é fantástico saber que foi possível a detecção", disse o astrônomo Greg Laughlin, da Universidade da Califórnia, em mensagem eletrônica.

Fonte: Revista Época

quinta-feira, 22 de dezembro de 2011

Pneus ficam mais verdes e mais doces

Os primeiros protótipos dos pneus "verdes e doces" já estão em testes, devendo chegar ao mercado em 3-5 anos.

Bio-pneus

Você gostaria de usar um pneu verde em seu carro?

Mas não se preocupe com a estética, uma vez que o verde refere-se a ambientalmente correto.

A Goodyear e a Michelin uniram-se com empresas do setor de biotecnologia para desenvolver novas matérias-primas para pneus - matérias-primas que sejam totalmente renováveis.

E a escolha está recaindo sobre o açúcar - logo, os pneus ambientalmente corretos serão não apenas verdes, mas também doces.

Os primeiros protótipos desses "bio-pneus" já estão prontos e em testes, embora as empresas afirmem que ainda levará de 3 a 5 anos para que eles cheguem ao mercado.

Bio-isopreno

A principal matéria-prima para os pneus é o petróleo, embora utilize-se também a borracha natural, que é renovável - gasta-se cerca de 30 litros de petróleo para fabricar um pneu de um carro médio.

A Genencor, empresa de biotecnologia parceira do projeto, desenvolveu micróbios que imitam o processo natural que a seringueira usa para produzir o látex.

Esses micróbios usam como matéria-prima o açúcar comum, produzindo um composto químico chamado isopreno, hoje um derivado do petróleo.

Trocando alimentos por pneus

A notícia não é boa para o mercado de etanol no Brasil.

As usinas geralmente optam por fabricar açúcar em vez de álcool por ser o açúcar uma commoditie internacional, cotada em dólar, enquanto o etanol tem um mercado predominantemente doméstico.

Uma maior demanda por açúcar deverá exercer uma pressão de alta no mercado internacional do produto, reforçando a necessidade do desenvolvimento do chamado biocombustível de segunda geração.

A iniciativa das empresas também deverá encontrar resistência por competir com os produtos alimentícios.

Enquanto, no Brasil, o etanol compete com o açúcar, nos Estados Unidos o biocombustível é feito sobretudo à base de milho.

Fonte: Inovação tecnológica

Bio-pneus

Você gostaria de usar um pneu verde em seu carro?

Mas não se preocupe com a estética, uma vez que o verde refere-se a ambientalmente correto.

A Goodyear e a Michelin uniram-se com empresas do setor de biotecnologia para desenvolver novas matérias-primas para pneus - matérias-primas que sejam totalmente renováveis.

E a escolha está recaindo sobre o açúcar - logo, os pneus ambientalmente corretos serão não apenas verdes, mas também doces.

Os primeiros protótipos desses "bio-pneus" já estão prontos e em testes, embora as empresas afirmem que ainda levará de 3 a 5 anos para que eles cheguem ao mercado.

Bio-isopreno

A principal matéria-prima para os pneus é o petróleo, embora utilize-se também a borracha natural, que é renovável - gasta-se cerca de 30 litros de petróleo para fabricar um pneu de um carro médio.

A Genencor, empresa de biotecnologia parceira do projeto, desenvolveu micróbios que imitam o processo natural que a seringueira usa para produzir o látex.

Esses micróbios usam como matéria-prima o açúcar comum, produzindo um composto químico chamado isopreno, hoje um derivado do petróleo.

Trocando alimentos por pneus

A notícia não é boa para o mercado de etanol no Brasil.

As usinas geralmente optam por fabricar açúcar em vez de álcool por ser o açúcar uma commoditie internacional, cotada em dólar, enquanto o etanol tem um mercado predominantemente doméstico.

Uma maior demanda por açúcar deverá exercer uma pressão de alta no mercado internacional do produto, reforçando a necessidade do desenvolvimento do chamado biocombustível de segunda geração.

A iniciativa das empresas também deverá encontrar resistência por competir com os produtos alimentícios.

Enquanto, no Brasil, o etanol compete com o açúcar, nos Estados Unidos o biocombustível é feito sobretudo à base de milho.

Fonte: Inovação tecnológica

Energia solar já atingiu nível de competitividade econômica

Este foi o levantamento mais criterioso já realizado até agora dos custos da energia solar, atualizando vários coeficientes técnicos assumidos incorretamente.

"Já é hora de parar de ver a energia solar como a boutique das fontes de energia."

Na verdade, ela nem mais deveria ser vista como uma fonte alternativa de energia, mas como "uma opção técnica e economicamente viável".

O recado contundente é do pesquisador Joshua Pearce, da Universidade Queens, no Canadá.

Pearce e seus colegas fizeram o levantamento mais criterioso já realizado até agora dos custos da energia solar.

E encontraram números que são muito diferentes dos que vêm sendo adotados na larga maioria dos estudos da área, na maioria das vezes sem critério e sem nenhum questionamento.

Custo da energia solar

"Historicamente, quando comparam a economia da energia solar e das fontes convencionais de energia, as pessoas têm sido muito conservadoras," diz o pesquisador, citando como "pessoas" os estudiosos que publicaram artigos científicos sobre o assunto.

O grupo de Pearce revisou todos esses estudos, publicados ao longo das últimas décadas, e descobriu que os números usados nas comparações de custos estão errados por uma larga margem.

Para descobrir o custo real da energia fotovoltaica é necessário considerar, além do custo dos painéis solares, os custos de instalação e de manutenção, o custo financeiro do investimento, a vida útil dos painéis e a potência efetiva que eles produzem ao longo do ano.

Coeficientes corretos

O primeiro erro encontrado foi na durabilidade dos painéis solares. "Com base nos últimos estudos de longo prazo, nós devemos fazer nossa análise econômica considerando um ciclo de vida de 30 anos, no mínimo," afirmou Pearce.

Além disso, a maioria das análises reproduz um dado que afirma que a produtividade dos painéis solares fotovoltaicos cai a uma taxa de 1% ao ano, quando o dado real, com base nos painéis disponíveis hoje no comércio, fica entre 0,1 e 0,2%.

Finalmente, as análises têm largas variações quanto ao custo por watt de eletricidade gerada, que é citado entre US$2 e US$10.

"O custo verdadeiro em 2011, para painéis solares disponíveis no mercado mundial, é de US$1," afirma Pearce, mesmo que os custos dos próprios painéis e da mão-de-obra para instalação variem largamente ao redor do mundo.

Competitiva

O estudo crítico refaz então os cálculos e conclui que a energia solar já está alcançou competitividade em várias partes do mundo.

Segundo os pesquisadores, os painéis solares já podem gerar uma eletricidade que é tão barata - em alguns lugares, mais barata - do que a energia que os consumidores compram hoje das concessionárias.

Isto sem atribuir um valor financeiro para os outros benefícios da energia solar, como a redução da poluição e a queda na emissão de carbono.

Fonte: Inovação tecnológica

segunda-feira, 19 de dezembro de 2011

Informação: O que é uma fonte chaveada?

Uma fonte chaveada ou comutada (em língua inglesa switched-mode power supply (SMPS)), é uma unidade de fonte de alimentação eletrônica que incorpora um regulador chaveado, ou seja; um circuito controlador interno que chaveia (comuta) a corrente, ligando e desligando rapidamente, de forma a manter uma tensão de saída estabilizada. Reguladores chaveados são utilizados para substituição de reguladores lineares mais simples, quando uma eficiência maior, menor tamanho e maior leveza são requiridos. Eles, entretanto, são mais complexos e mais caros, e o chaveamento da corrente pode causar problemas de ruído (tanto eletromagnético quanto sonoro) se não forem cuidadosamente suprimidos, e projetos simples podem ter baixo fator de potência.

As fontes chaveadas podem ser classificadas de acordo com a forma de onda da tensão de entrada e de saída conforme segue:

-Entrada CA, saída CC: retificador

-Entrada CC, saída CC: conversor de tensão, ou conversor de corrente ou conversor CC/CC

-Entrada CA, saída CA: Conversor de freqüência, cicloconversor

-Entrada CC, saída CA: inversor

Sendo que CA e CC correspondem, respectivamente, às abreviações de corrente alternada e corrente contínua.

Vista interna de uma Fonte Chaveada ATX comum em computadores.

A - retificador em ponte

B - capacitores de filtro de entrada

C - transformador

D - indutores de filtro de saída

E - capacitores de filtro de saída

Fonte chaveada comparada com fonte linear

Tamanho e peso. Fontes de alimentação linear utilizam um tranformador operando na freqüência de 50/60 Hz e filtros de linha. Esses componentes são maiores e mais pesados que os correspondentes ao de uma fonte chaveada, que opera em alta freqüências.

Eficiência. Fontes lineares regulam sua tensão de saída criando uma tensão mais alta que a necessária e então reduzindo-a, convertendo parte dessa energia elétrica em calor. Essa perda é numa parte necessária para o funcionamento do circuito e não pode ser eliminada para melhoria do projeto. Fontes chaveadas não criam tensões maiores que a necessária e apenas pequenas quantidades de energia são dissipadas.

Potência dissipada. Esta é determinada pele eficiência supracitada. Fontes lineares produzem muito mais calor do que as chaveadas.

Complexidade. Fontes lineares são simples o suficiente para serem projetadas por iniciantes. Fontes chaveadas são complicadas, difícil de projetá-las, e o grande número de componentes faz com que seja mais cara para montá-la e para repará-la.

Ruído. Existe o chaveamento da corrente em fontes chaveadas que contêm energia em altas freqüências ao contrário das fontes lineares. Isto é devido ao seu oscilador interno operando em torno de 60kHz. Essa energia em alta freqüência, na faixa de RF (rádio freqüência), facilmente irradia indução eletromagnética aos equipamentos próximos, ou como as ondas de rádio em longas distâncias, causam interferência. Por isso, deve-se tomar cuidado para eliminar essa energia na fonte através de filtros e um bom projeto eletrônico, e/ou contê-las através de blindagem.Existe também o problema do ruído sonoro, já que por questões de tamanho fontes chaveadas costumam usar ventoinhas e ventiladores para resfriar os dissipadores de calor, que seriam bem maiores se assim não o fossem ( obs: um outro tipo de ruído é o som do chaveamento de alta frequência da fonte, fora da faixa audível humana, e que normalmente não incomoda).

Fator de potência. Se a corrente utilizada por uma carga, tal como uma fonte chaveada, retirada de uma fonte CA não for senoidal e/ou fora de fase com forma de onda da rede, então o fator de potência será menor que o unitário, diminuindo a eficiência e a capacidade da linha de transmissão consideravelmente. As mais simples e mais comuns fontes chaveadas possuem fator de potência em torno de 0,6 , e seu uso crescente em microcomputadores e lâmpadas fluorescentes compactas apresenta um problema em ascensão. Os circuitos de correção de fator de potência podem reduzir este problema, sendo obrigados por normas em certos países.

Risco de choque elétrico. Uma fonte chaveada simples trabalha em seus circuitos de entrada diretamente ligada a rede elétrica sem isolação, diferente de uma fonte linear que usa fusíveis e fios isolados antes do transformador, com menor risco de choque. Por isso o perigo para quem repara ou eventuais curiosos que retiram a tampa das fontes. Choques, mesmos pequenos, podem ser perigosos a vida. Observe que alguns tipos de fontes chaveada mantém a carga em seus capacitores, mesmo depois de desligadas da rede elétrica, ou seja; você pode levar um choque carregando uma placa dessas sem a tampa na mão, algo que gira em torno de 300 volts!

As fontes chaveadas podem ser classificadas de acordo com a forma de onda da tensão de entrada e de saída conforme segue:

-Entrada CA, saída CC: retificador

-Entrada CC, saída CC: conversor de tensão, ou conversor de corrente ou conversor CC/CC

-Entrada CA, saída CA: Conversor de freqüência, cicloconversor

-Entrada CC, saída CA: inversor

Sendo que CA e CC correspondem, respectivamente, às abreviações de corrente alternada e corrente contínua.

Vista interna de uma Fonte Chaveada ATX comum em computadores.

A - retificador em ponte

B - capacitores de filtro de entrada

C - transformador

D - indutores de filtro de saída

E - capacitores de filtro de saída

Fonte chaveada comparada com fonte linear

Tamanho e peso. Fontes de alimentação linear utilizam um tranformador operando na freqüência de 50/60 Hz e filtros de linha. Esses componentes são maiores e mais pesados que os correspondentes ao de uma fonte chaveada, que opera em alta freqüências.

Eficiência. Fontes lineares regulam sua tensão de saída criando uma tensão mais alta que a necessária e então reduzindo-a, convertendo parte dessa energia elétrica em calor. Essa perda é numa parte necessária para o funcionamento do circuito e não pode ser eliminada para melhoria do projeto. Fontes chaveadas não criam tensões maiores que a necessária e apenas pequenas quantidades de energia são dissipadas.

Potência dissipada. Esta é determinada pele eficiência supracitada. Fontes lineares produzem muito mais calor do que as chaveadas.

Complexidade. Fontes lineares são simples o suficiente para serem projetadas por iniciantes. Fontes chaveadas são complicadas, difícil de projetá-las, e o grande número de componentes faz com que seja mais cara para montá-la e para repará-la.

Ruído. Existe o chaveamento da corrente em fontes chaveadas que contêm energia em altas freqüências ao contrário das fontes lineares. Isto é devido ao seu oscilador interno operando em torno de 60kHz. Essa energia em alta freqüência, na faixa de RF (rádio freqüência), facilmente irradia indução eletromagnética aos equipamentos próximos, ou como as ondas de rádio em longas distâncias, causam interferência. Por isso, deve-se tomar cuidado para eliminar essa energia na fonte através de filtros e um bom projeto eletrônico, e/ou contê-las através de blindagem.Existe também o problema do ruído sonoro, já que por questões de tamanho fontes chaveadas costumam usar ventoinhas e ventiladores para resfriar os dissipadores de calor, que seriam bem maiores se assim não o fossem ( obs: um outro tipo de ruído é o som do chaveamento de alta frequência da fonte, fora da faixa audível humana, e que normalmente não incomoda).

Fator de potência. Se a corrente utilizada por uma carga, tal como uma fonte chaveada, retirada de uma fonte CA não for senoidal e/ou fora de fase com forma de onda da rede, então o fator de potência será menor que o unitário, diminuindo a eficiência e a capacidade da linha de transmissão consideravelmente. As mais simples e mais comuns fontes chaveadas possuem fator de potência em torno de 0,6 , e seu uso crescente em microcomputadores e lâmpadas fluorescentes compactas apresenta um problema em ascensão. Os circuitos de correção de fator de potência podem reduzir este problema, sendo obrigados por normas em certos países.

Risco de choque elétrico. Uma fonte chaveada simples trabalha em seus circuitos de entrada diretamente ligada a rede elétrica sem isolação, diferente de uma fonte linear que usa fusíveis e fios isolados antes do transformador, com menor risco de choque. Por isso o perigo para quem repara ou eventuais curiosos que retiram a tampa das fontes. Choques, mesmos pequenos, podem ser perigosos a vida. Observe que alguns tipos de fontes chaveada mantém a carga em seus capacitores, mesmo depois de desligadas da rede elétrica, ou seja; você pode levar um choque carregando uma placa dessas sem a tampa na mão, algo que gira em torno de 300 volts!

Estabilizador ou filtro de linha? Entenda para que servem estes equipamentos

Antes de chegar às tomadas, a energia elétrica percorre longas distâncias e sofre alterações em suas características. Embora os sistemas de geração, transmissão e distribuição sejam projetados para oferecer energia elétrica ininterruptamente, a enorme quantidade de usuários e equipamentos conectados a esta rede somada à falta de manutenção em cabos e transformadores podem gerar curto-circuitos, blecautes, surtos e oscilações de tensão na corrente elétrica.

Distúrbios no fornecimento de energia da rede da concessionária, mesmo imperceptíveis para o ser humano, podem causar danos a equipamentos eletroeletrônicos, estejam eles energizados ou não, simplesmente por estarem conectados na tomada. Instalações elétricas inadequadas – tais como fiação mal dimensionada para o tipo de tensão exigida (os fios podem aquecer demasiadamente e até entrar em curto-circuito ou combustão) ou falta de aterramento – também podem ocasionar falhas no funcionamento de eletrônicos.

Isso ocorre porque a as redes elétricas entregam energia com tensão de 110 volts (V) e 220 V, em corrente alternada. O computador ‘funciona’ com essa tensão, mas seus componentes, contudo, operam em corrente contínua com tensão entre 3 V e 12 V. Para que esse suprimento seja fornecido adequadamente, os computadores possuem uma fonte de alimentação que faz a transformação necessária para o abastecimento de cada componente.

Essas fontes foram projetadas para receber a energia elétrica da rede da concessionária dentre de uma determinada tensão. Variações bruscas podem acarretar problemas simples em um PC que esteja em funcionamento, como travamento do teclado e vibrações no monitor, ou prejuízos sérios como a queima de computadores e seus periféricos.

Tais variações podem ser de vários tipos: sobretensão (elevação brusca dos níveis de tensão), subtensão (diminuição brusca nos níveis de tensão), transiente (pequena variação de tensão devido ao acionamento de aparelhos elétricos caseiros), quedas de tensão (falta de energia por tempo prolongado) e pico de tensão (variações elevadas nos níveis de tensão por curtos períodos).

Existem no mercado dois tipos de dispositivos utilizados para proteger os computadores e periféricos desses problemas, filtros de linha e estabilizadores de tensão, cujas funcionalidades são bem diferentes.

Filtros de linha

O filtro de linha elimina ou minimiza os ‘ruídos’ da rede elétrica, que normalmente ocorrem por causa de transientes. “Esses ruídos podem ser gerados por outros equipamentos conectados a rede, como motores, fontes chaveadas e aparelhos de solda ou ainda por descargas atmosféricas Eles interferem no funcionamento normal do computador, levando muitas vezes à perda de dados, enquanto os surtos de tensão podem queimar partes sensíveis do PC”, diz Valdelírio Soares, presidente da Microsol.

Além de remover ruídos e picos de tensão, os filtros de linha têm outras finalidades básicas. Por exemplo, ele expande o número de tomadas disponíveis perto do PC ou de equipamentos de áudio/vídeo e protege contra curto-circuitos e sobrecarga de tensão. Isso é possível porque a maioria dos filtros de linha possui um disjuntor (ou fusível) responsável por desligar a alimentação elétrica, caso a corrente total exigida pelo equipamento seja maior do que a corrente rotulada. No caso de dispositivos protegidos por fusível, em caso de sobretensão, esse se funde, sendo necessária sua substituição para que o filtro de linha volte a funcionar corretamente.

Como o mercado por filtros de linha é grande, existem muitos fabricantes que colocam produtos à venda e que não trazem todos os componentes de proteção necessários para uma boa filtragem de interferências eletromagnéticas e de picos de tensão. Alguns equipamentos não têm nem mesmo qualquer componente de filtragem, funcionando apenas como uma mera extensão.

Filtros de linha baratos não têm componentes para filtragem eletromagnética, apesar de terem pelo menos um varistor – pequeno componente eletrônico que oferece proteção contra descargas elétricas de curta duração. Bons filtros de linha têm tanto varistores quanto componentes para filtragem eletromagnética. A partir de janeiro de 2008, todo estabilizador deverá ter um filtro de linha interno, segundo a nova norma do Instituto Nacional de Metrologia, Normalização e Qualidade Industrial (Inmetro).

Como comprar um filtro de linha - Se estiver realmente preocupado em proteger seu equipamento, você não deve economizar na hora de adquirir um filtro de linha. Recomendamos que escolha um que tenha pelo menos três varistores. Como saber isso? Se na caixa do produto ou em suas especificações técnicas estiver escrito algo como “L-N, L-G, N-G”, isso significa que o filtro de linha tem pelo menos três varistores.

Procure por um filtro de linha com a menor tensão de ativação (330 V é o mínimo atualmente) – este parâmetro vai estar descrito como “clamping voltage”. Tensão de ativação é a tensão a partir da qual os varistores começam funcionar. O ideal é que eles comecem a funcionar no exato momento em que o pico de tensão ocorrer.

Outro detalhe importante é o tempo de resposta, que é o intervalo necessário para que o filtro de linha comece a funcionar quando um pico de tensão é detectado. Há ainda a corrente de pico, que é a corrente máxima de pico que os varistores conseguem suportar sem queimar. Quanto mais alto, melhor.

E, por fim, existe o nível de absorção de energia, medido em Joules. Ele mostra a quantidade de pico de energia que o filtro de linha suporta antes de queimar seus varistores.

Estabilizadores

O segundo tipo de equipamento de proteção comumente utilizado são os estabilizadores de tensão. Eles são desenvolvidos para proteger os eletrônicos das variações bruscas de tensão como a sobretensão e a subtensão. Sua função é regular a tensão elétrica que chega da rede da concessionária e entregar para os computadores o nível de tensão adequado e constante exigido pelas fontes de alimentação.

“O estabilizador é um equipamento que corrige as diferenças de tensão da rede. Ou seja, ajustam a tensão da energia para que os equipamentos conectados recebam a energia mais próxima da ideal. Isto significa que, se a rede estiver baixa, o estabilizador a eleva e mantém a tensão dentro de limites aceitáveis. Caso a rede esteja alta, o equipamento faz a correção inversa”, explica a gerente de marketing da SMS Tecnologia Eletrônica, Gisella Magni. “A subtensão pode impedir ou atrapalhar o funcionamento do computador e a sobretensão pode levar à queima do computador, especialmente a fonte e a placa-mãe”, complementa Soares, da Microsol.

O computador e todos seus periféricos devem ser ligados no estabilizador. No entanto, é importante observar que a soma das potências dos equipamentos ligados ao estabilizador não pode ser maior do que a potência nominal dele. De acordo com Soares, a ordem ideal para a conexão dos equipamentos à rede elétrica para a melhor proteção possível é: tomada, filtro de linha, estabilizador e, neste, o computador e seus periféricos.

Proteção extra - Caso o usuário esteja disposto a garantir ainda mais proteção aos seus equipamentos de informática, o ideal é adquirir uma unidade de fornecimento de energia. Também conhecidos por Uninterruptable Power Supply (UPS) ou nobreak, esses equipamentos asseguram o fornecimento de energia para o computador e periféricos no caso de falta de energia e oferecem proteção total contra problemas que vão desde pequenas interrupções em frações de segundos até blecaute total, e também contra ruídos, sobretensões e subtensões.

Esses equipamentos podem tanto funcionar por apenas alguns minutos, para que o usuário possa desligar normalmente o computador sem perda de dados e, neste caso, são chamados shortbreakes, quanto podem funcionar por longos períodos. Sua autonomia depende da potência de sua baterias e também da quantidade de equipamentos que estiverem ligados a ele.

Fonte: PCWORLD

Distúrbios no fornecimento de energia da rede da concessionária, mesmo imperceptíveis para o ser humano, podem causar danos a equipamentos eletroeletrônicos, estejam eles energizados ou não, simplesmente por estarem conectados na tomada. Instalações elétricas inadequadas – tais como fiação mal dimensionada para o tipo de tensão exigida (os fios podem aquecer demasiadamente e até entrar em curto-circuito ou combustão) ou falta de aterramento – também podem ocasionar falhas no funcionamento de eletrônicos.

Isso ocorre porque a as redes elétricas entregam energia com tensão de 110 volts (V) e 220 V, em corrente alternada. O computador ‘funciona’ com essa tensão, mas seus componentes, contudo, operam em corrente contínua com tensão entre 3 V e 12 V. Para que esse suprimento seja fornecido adequadamente, os computadores possuem uma fonte de alimentação que faz a transformação necessária para o abastecimento de cada componente.

Essas fontes foram projetadas para receber a energia elétrica da rede da concessionária dentre de uma determinada tensão. Variações bruscas podem acarretar problemas simples em um PC que esteja em funcionamento, como travamento do teclado e vibrações no monitor, ou prejuízos sérios como a queima de computadores e seus periféricos.

Tais variações podem ser de vários tipos: sobretensão (elevação brusca dos níveis de tensão), subtensão (diminuição brusca nos níveis de tensão), transiente (pequena variação de tensão devido ao acionamento de aparelhos elétricos caseiros), quedas de tensão (falta de energia por tempo prolongado) e pico de tensão (variações elevadas nos níveis de tensão por curtos períodos).

Existem no mercado dois tipos de dispositivos utilizados para proteger os computadores e periféricos desses problemas, filtros de linha e estabilizadores de tensão, cujas funcionalidades são bem diferentes.

Filtros de linha

O filtro de linha elimina ou minimiza os ‘ruídos’ da rede elétrica, que normalmente ocorrem por causa de transientes. “Esses ruídos podem ser gerados por outros equipamentos conectados a rede, como motores, fontes chaveadas e aparelhos de solda ou ainda por descargas atmosféricas Eles interferem no funcionamento normal do computador, levando muitas vezes à perda de dados, enquanto os surtos de tensão podem queimar partes sensíveis do PC”, diz Valdelírio Soares, presidente da Microsol.

Além de remover ruídos e picos de tensão, os filtros de linha têm outras finalidades básicas. Por exemplo, ele expande o número de tomadas disponíveis perto do PC ou de equipamentos de áudio/vídeo e protege contra curto-circuitos e sobrecarga de tensão. Isso é possível porque a maioria dos filtros de linha possui um disjuntor (ou fusível) responsável por desligar a alimentação elétrica, caso a corrente total exigida pelo equipamento seja maior do que a corrente rotulada. No caso de dispositivos protegidos por fusível, em caso de sobretensão, esse se funde, sendo necessária sua substituição para que o filtro de linha volte a funcionar corretamente.

Como o mercado por filtros de linha é grande, existem muitos fabricantes que colocam produtos à venda e que não trazem todos os componentes de proteção necessários para uma boa filtragem de interferências eletromagnéticas e de picos de tensão. Alguns equipamentos não têm nem mesmo qualquer componente de filtragem, funcionando apenas como uma mera extensão.

Filtros de linha baratos não têm componentes para filtragem eletromagnética, apesar de terem pelo menos um varistor – pequeno componente eletrônico que oferece proteção contra descargas elétricas de curta duração. Bons filtros de linha têm tanto varistores quanto componentes para filtragem eletromagnética. A partir de janeiro de 2008, todo estabilizador deverá ter um filtro de linha interno, segundo a nova norma do Instituto Nacional de Metrologia, Normalização e Qualidade Industrial (Inmetro).

Como comprar um filtro de linha - Se estiver realmente preocupado em proteger seu equipamento, você não deve economizar na hora de adquirir um filtro de linha. Recomendamos que escolha um que tenha pelo menos três varistores. Como saber isso? Se na caixa do produto ou em suas especificações técnicas estiver escrito algo como “L-N, L-G, N-G”, isso significa que o filtro de linha tem pelo menos três varistores.

Procure por um filtro de linha com a menor tensão de ativação (330 V é o mínimo atualmente) – este parâmetro vai estar descrito como “clamping voltage”. Tensão de ativação é a tensão a partir da qual os varistores começam funcionar. O ideal é que eles comecem a funcionar no exato momento em que o pico de tensão ocorrer.

Outro detalhe importante é o tempo de resposta, que é o intervalo necessário para que o filtro de linha comece a funcionar quando um pico de tensão é detectado. Há ainda a corrente de pico, que é a corrente máxima de pico que os varistores conseguem suportar sem queimar. Quanto mais alto, melhor.

E, por fim, existe o nível de absorção de energia, medido em Joules. Ele mostra a quantidade de pico de energia que o filtro de linha suporta antes de queimar seus varistores.

Estabilizadores

O segundo tipo de equipamento de proteção comumente utilizado são os estabilizadores de tensão. Eles são desenvolvidos para proteger os eletrônicos das variações bruscas de tensão como a sobretensão e a subtensão. Sua função é regular a tensão elétrica que chega da rede da concessionária e entregar para os computadores o nível de tensão adequado e constante exigido pelas fontes de alimentação.

“O estabilizador é um equipamento que corrige as diferenças de tensão da rede. Ou seja, ajustam a tensão da energia para que os equipamentos conectados recebam a energia mais próxima da ideal. Isto significa que, se a rede estiver baixa, o estabilizador a eleva e mantém a tensão dentro de limites aceitáveis. Caso a rede esteja alta, o equipamento faz a correção inversa”, explica a gerente de marketing da SMS Tecnologia Eletrônica, Gisella Magni. “A subtensão pode impedir ou atrapalhar o funcionamento do computador e a sobretensão pode levar à queima do computador, especialmente a fonte e a placa-mãe”, complementa Soares, da Microsol.

O computador e todos seus periféricos devem ser ligados no estabilizador. No entanto, é importante observar que a soma das potências dos equipamentos ligados ao estabilizador não pode ser maior do que a potência nominal dele. De acordo com Soares, a ordem ideal para a conexão dos equipamentos à rede elétrica para a melhor proteção possível é: tomada, filtro de linha, estabilizador e, neste, o computador e seus periféricos.

Proteção extra - Caso o usuário esteja disposto a garantir ainda mais proteção aos seus equipamentos de informática, o ideal é adquirir uma unidade de fornecimento de energia. Também conhecidos por Uninterruptable Power Supply (UPS) ou nobreak, esses equipamentos asseguram o fornecimento de energia para o computador e periféricos no caso de falta de energia e oferecem proteção total contra problemas que vão desde pequenas interrupções em frações de segundos até blecaute total, e também contra ruídos, sobretensões e subtensões.

Esses equipamentos podem tanto funcionar por apenas alguns minutos, para que o usuário possa desligar normalmente o computador sem perda de dados e, neste caso, são chamados shortbreakes, quanto podem funcionar por longos períodos. Sua autonomia depende da potência de sua baterias e também da quantidade de equipamentos que estiverem ligados a ele.

Fonte: PCWORLD

sábado, 17 de dezembro de 2011

Microgerador transforma movimento dos pneus em eletricidade

Energia dos pneus

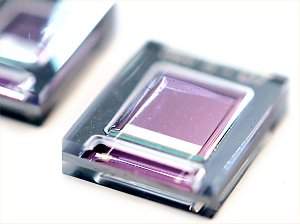

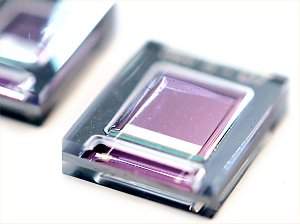

Além do material piezoelétrico para produzir eletricidade, o pequeno gerador possui capacitores para armazená-la, melhorando a estabilidade do fornecimento de energia.

O laboratório belga IMEC criou um minúsculo gerador capaz de produzir energia a partir das vibrações normais dos pneus durante o movimento de um carro.

O "dispositivo de colheita de energia" é capaz de gerar 42 microWatts de potência de forma sustentada quando o veículo roda a 70 km/h.

Em condições especiais de rodagem, ele chegou a gerar quase 12 vezes mais - 489 microWatts.

Contudo, os 42 microWatts são suficientes para alimentar sensores, como os usados nos sistemas de monitoramento da pressão dos pneus, já presentes em alguns carros - a vantagem é que esses sistemas não mais dependerão da troca de baterias.

O aparelho deverá também viabilizar automações adicionais, como sensores para monitorar a qualidade da estrada, ajustando automaticamente a suspensão, sistemas de segurança, detectando estilos de direção mais agressivos, e mesmo um monitoramento da integridade estrutural dos pneus.

Indústria e meio ambiente

Mas o coletor de energia não terá seus usos restritos à indústria automotiva.

Ele poderá ser instalado em qualquer equipamento que apresente algum tipo de vibração ou esteja sujeito a choques periódicos.

Isto inclui desde máquinas industriais até o monitoramento de estruturas civis, como pontes e edifícios, viabilizando ainda as redes de sensores, que deverão ser usadas para monitorar o meio ambiente e até a integridade estrutural de aviões.

O chip coletor de energia usa minúsculas vigas feitas de um material piezoelétrico, o nitreto de alumínio, que gera eletricidade quando é submetido a um impacto mecânico.

Fonte: Site Inovação Tecnológica.

Além do material piezoelétrico para produzir eletricidade, o pequeno gerador possui capacitores para armazená-la, melhorando a estabilidade do fornecimento de energia.

O laboratório belga IMEC criou um minúsculo gerador capaz de produzir energia a partir das vibrações normais dos pneus durante o movimento de um carro.

O "dispositivo de colheita de energia" é capaz de gerar 42 microWatts de potência de forma sustentada quando o veículo roda a 70 km/h.

Em condições especiais de rodagem, ele chegou a gerar quase 12 vezes mais - 489 microWatts.

Contudo, os 42 microWatts são suficientes para alimentar sensores, como os usados nos sistemas de monitoramento da pressão dos pneus, já presentes em alguns carros - a vantagem é que esses sistemas não mais dependerão da troca de baterias.

O aparelho deverá também viabilizar automações adicionais, como sensores para monitorar a qualidade da estrada, ajustando automaticamente a suspensão, sistemas de segurança, detectando estilos de direção mais agressivos, e mesmo um monitoramento da integridade estrutural dos pneus.

Indústria e meio ambiente

Mas o coletor de energia não terá seus usos restritos à indústria automotiva.

Ele poderá ser instalado em qualquer equipamento que apresente algum tipo de vibração ou esteja sujeito a choques periódicos.

Isto inclui desde máquinas industriais até o monitoramento de estruturas civis, como pontes e edifícios, viabilizando ainda as redes de sensores, que deverão ser usadas para monitorar o meio ambiente e até a integridade estrutural de aviões.

O chip coletor de energia usa minúsculas vigas feitas de um material piezoelétrico, o nitreto de alumínio, que gera eletricidade quando é submetido a um impacto mecânico.

Fonte: Site Inovação Tecnológica.

quarta-feira, 14 de dezembro de 2011

Nasa anuncia descoberta de planeta que pode ter água

O planeta Kepler-22b é o menor encontrado pela sonda espacial a orbitar uma estrela similar à da Terra na "zona habitável", aquela onde as temperaturas permitem o desenvolvimento da vida

Concepção artística do planeta Kepler-22, planeta encontrado pela Nasa que está na chamada "zona habitável", região onde se acredita que pode haver água líquida (Foto: Divulgação/Nasa)

O observatório espacial Kepler descobriu no sistema planetário Kepler-22, a 600 anos-luz de distância, o primeiro planeta situado na chamada "zona habitável", em uma região onde se acredita que pode haver água líquida, anunciou a Nasa nesta segunda-feira (5) em entrevista coletiva. Os cientistas do Centro de Pesquisa Ames da Nasa anunciaram, além disso, que Kepler identificou mil novos candidatos a planeta, dez dos quais possuem tamanho similar ao da Terra e orbitam na zona habitável da estrela de seu sistema solar.

O planeta Kepler-22b é o menor encontrado pela sonda espacial a orbitar uma estrela similar à da Terra na "zona habitável", aquela onde as temperaturas permitem o desenvolvimento da vida. Apesar de não saber se o planeta, que é maior que a Terra, é rochoso, gasoso ou líquido, a subdiretora da equipe de cientistas do Centro Ames, Natalie Batalha, afirmou: "estamos cada vez mais perto de encontrar um planeta parecido com a Terra".

O observatório Kepler já tinha dado pistas anteriormente da existência de planetas com dimensões parecidas com o nosso orbitando em "zonas habitáveis", mas esta é a primeira vez que o fato é registrado.

Os cientistas, além da descoberta, também atualizaram o número dos candidatos a planetas na lista que começou a ser elaborada em 2009. Agora são 2.326 planetas, 207 possuem tamanho semelhante ao da Terra, 680 são maiores e se denominam "super Terras". Entre os restantes, 1.181 possuem o tamanho de Netuno, 203 são equivalentes às dimensões de Júpiter e 55 são ainda maiores que Júpiter, o maior planeta de nosso Sistema Solar.

Fonte: Revista Época

Concepção artística do planeta Kepler-22, planeta encontrado pela Nasa que está na chamada "zona habitável", região onde se acredita que pode haver água líquida (Foto: Divulgação/Nasa)

O observatório espacial Kepler descobriu no sistema planetário Kepler-22, a 600 anos-luz de distância, o primeiro planeta situado na chamada "zona habitável", em uma região onde se acredita que pode haver água líquida, anunciou a Nasa nesta segunda-feira (5) em entrevista coletiva. Os cientistas do Centro de Pesquisa Ames da Nasa anunciaram, além disso, que Kepler identificou mil novos candidatos a planeta, dez dos quais possuem tamanho similar ao da Terra e orbitam na zona habitável da estrela de seu sistema solar.

O planeta Kepler-22b é o menor encontrado pela sonda espacial a orbitar uma estrela similar à da Terra na "zona habitável", aquela onde as temperaturas permitem o desenvolvimento da vida. Apesar de não saber se o planeta, que é maior que a Terra, é rochoso, gasoso ou líquido, a subdiretora da equipe de cientistas do Centro Ames, Natalie Batalha, afirmou: "estamos cada vez mais perto de encontrar um planeta parecido com a Terra".

O observatório Kepler já tinha dado pistas anteriormente da existência de planetas com dimensões parecidas com o nosso orbitando em "zonas habitáveis", mas esta é a primeira vez que o fato é registrado.

Os cientistas, além da descoberta, também atualizaram o número dos candidatos a planetas na lista que começou a ser elaborada em 2009. Agora são 2.326 planetas, 207 possuem tamanho semelhante ao da Terra, 680 são maiores e se denominam "super Terras". Entre os restantes, 1.181 possuem o tamanho de Netuno, 203 são equivalentes às dimensões de Júpiter e 55 são ainda maiores que Júpiter, o maior planeta de nosso Sistema Solar.

Fonte: Revista Época

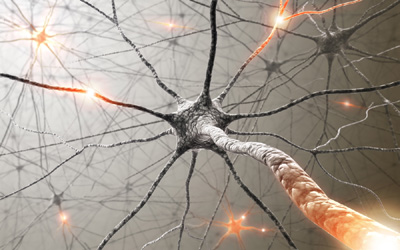

Por que não podemos ser mais inteligentes do que somos

Cientistas descobriram que melhorar em memória, atenção ou raciocínio pode piorar o desempenho em outras funções cognitivas

A inteligência sempre foi uma característica essencial para a sobrevivência e a evolução dos seres humanos. Nossa capacidade de resolver problemas complexos, trabalhar de forma cooperativa e entender a passagem do tempo estão por trás do nosso sucesso de nossa espécie.

Mas se a inteligência é assim tão fundamental para a sobrevivência da espécie, por que não somos ainda mais inteligentes – ou seja, mais adaptados aos desafios representados pelo mundo – do que somos?

Pesquisadores da Universidade de Warwick, na Inglaterra, descobriram que a equação não é assim tão simples. Eles concluíram que melhorias em funções cognitivas como a memória, a atenção e o raciocínio trariam uma piora do desempenho de outras. Para os cientistas, a ideia de um super-cérebro só seria possível na ficção científica.

Para chegar a essa conclusão, o psicólogo Thomas Hills, de Warwick, e Ralph Hertwig, da Universidade de Basel, analisaram estudos de vários tipos, entre eles pesquisas sobre a mente dos autistas e sobre os efeitos de remédios como a Ritalina, que aumentam a atenção.

Eles descobriram que, em geral, indivíduos com habilidades cognitivas muito elevadas – como pessoas que têm uma memória fotográfica, muito acima do normal – geralmente têm também algum tipo de transtorno, como autismo e problemas neurológicos associados ao crescimento cerebral. E mesmo os remédios que melhoram a atenção podem ter um efeito negativo: para quem não tem problema de foco e se medica na esperança de melhorar o desempenho nas tarefas cotidianas, o resultado pode ser exatamente o oposto.

Segundo Hills, o estudo sugere que há um limite para melhorar as funções cognitivas. Um exemplo simples é o uso de cafeína para aumentar a atenção. A pessoa pode até ficar mais alerta, mas seu nível de ansiedade pode aumentar e sua coordenação motora fina pode piorar.

A mensagem é que não dá para ter tudo ao mesmo tempo. Ir além em uma habilidade é, necessariamente, deixar outras para trás.

Fonte: Revista Época

Meio ambiente: Programa gratuito automatiza controle da irrigação

O software permite o manejo racional da água utilizada na agricultura irrigada. [Imagem: Divulgação]

Agricultura irrigada

A Universidade Estadual Paulista (Unesp), campus de Ilha Solteira, disponibilizou um software para o manejo racional da água utilizada na agricultura irrigada.

O SMAI (Sistema para Manejo da Agricultura Irrigada), foi idealizado pela equipe do professor Fernando Braz Tangerino Hernandez.

De acordo com os pesquisadores, o desenvolvimento do software levou dez meses e seus principais benefícios são estimar rapidamente a evapotranspiração, que é a perda de água do solo por evaporação e a perda de água da planta por transpiração.

Evapotranspiração

O programa pode ser aplicado em todas as culturas.

"Ele é muito versátil. Se o usuário dispuser de todas as variáveis climáticas, vai usá-las para a estimativa da evapotranspiração de referência. Caso falte alguma, pode estimá-la pelas equações já existentes", explicou.

O programa é capaz de apresentar a taxa dos dois tipos de evapotranspiração: a de referência, um índice calculado com base em uma cultura hipotética que cobre todo o solo, como a grama; e a de cultura, uma conta feita para uma espécie vegetal específica.

Para isso, o sistema usa o método mais preciso da atualidade, que é a equação de Penman-Monteith, a mesma fórmula empregada pela Organização das Nações Unidas para Agricultura e Alimentação (FAO-ONU).

Sem adaptações

Hernandez afirma que a ferramenta foi desenvolvida pensando na simplicidade do uso.

"Um tutorial mostra como entrar com os dados a partir de uma planilha e, caso falte alguma das variáveis, ela é estimada por rotinas internas. Não acreditamos que o usuário tenha dificuldades em utilizá-lo", disse.

O software pode ser utilizado em qualquer região, sem a necessidade de adaptações.

"Talvez a maior dificuldade seja o usuário dispor das variáveis climáticas da região de interesse e também a divulgação das mesmas diariamente. Essa seria a situação ideal para que de fato o software possa ser utilizado para manejo da irrigação," afirmou.

O programa está disponível para download gratuito no endereço clima.feis.unesp.br/smai.

Fonte: Site Inovação Tecnológica

terça-feira, 13 de dezembro de 2011

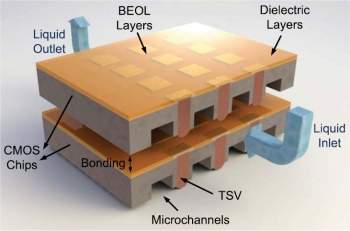

Eletrônica: "Metal líquido" fornece energia e retira calor de chip 3D

Embora os engenheiros se refiram a "metal líquido", trata-se na verdade de um eletrólito contendo íons de vanádio dissolvidos.

Inspirado no cérebro

Engenheiros da IBM idealizaram um meio para alimentar e retirar calor de processadores usando "metal líquido".

A empresa já havia anunciado que usaria água para refrigerar seus processadores 3D.

Mais recentemente, outro anúncio dava conta do desenvolvimento de uma cola para unir até 100 núcleos em um processador 3-D, embora o problema do aquecimento não estivesse resolvido.

Mas agora a idéia é bem diferente, e muito mais radical.

O engenheiro Bruno Michel, que está coordenando o projeto no laboratório da IBM em Zurique, conta que a inspiração veio do cérebro humano.

"O cérebro humano é 10.000 vezes mais denso e mais eficiente do que qualquer computador atual. Isto é possível porque ele usa uma única e altamente eficiente rede de capilares e vasos sanguíneos para transportar tanto calor quanto energia, tudo ao mesmo tempo," afirmou Michel.

Metal dissolvido

A ideia continua sendo empilhar os núcleos e criar canais entre eles.

O que mudou é que os canais não servirão apenas para refrigeração.

Serão duas redes microfluídicas separando os núcleos. A primeira conduzirá um fluido eletrificado, para alimentar o chip. A outra pegará o mesmo fluido - que já terá coletado o calor do processador, ao circular por ele - e o levará para fora, retirando o calor.

Michel afirma que seu grupo já demonstrou que é possível usar o "metal líquido" para transferir energia através da rede de canais.

Embora o engenheiro se refira a "metal líquido", trata-se na verdade de um eletrólito contendo íons de vanádio em solução - vanádio verdadeiramente liquefeito derreteria qualquer processador, uma vez que o metal tem um ponto de fusão de 1.910 ºC.

Supercomputador em um celular

Enquanto a Terrazon fabrique chips 3-D desde 2003, e o laboratório belga IMEC há menos tempo, o chip com alimentação fluídica da IBM ainda está na fase de projeto.

O próximo passo será construir um protótipo funcional de um processador 3D alimentado e refrigerado com a nova técnica, o que deverá ocorrer até 2014.

Mesmo não tendo ainda todos os parâmetros para calcular os ganhos em termos de dissipação de energia, Michel garante que eles são estrondosos: o suficiente para colocar um supercomputador dentro de um telefone celular.

Talvez, então, calcular as chances de o Brasil ser campeão depois de cada rodada da Copa do Mundo não será assim tão difícil.

Bateria de fluxo redox

O fluxo de íons metálicos para alimentar o processador 3D e retirar seu calor é na verdade um tipo de bateria, conhecida como bateria de fluxo redox.

O termo redox refere-se a uma reação de oxidação-redução - a bateria aproveita a energia liberada quando o estado de oxidação de um composto se altera.

Para a alimentação e refrigeração do chip, dois eletrólitos são bombeados de dois tanques externos para dentro do processador 3D, seguindo dois canais paralelos.

Esses eletrólitos contêm dois tipos diferentes de íons de vanádio, e os elétrons irão fluir de um para o outro em um circuito externo, criando a corrente elétrica que alimentará o chip.

Para recarregar a bateria, basta aplicar uma tensão aos seus eletrodos, revertendo o processo.

Uma bateria de fluxo é ideal para os chips por causa de sua elevada densidade energética.

Até agora elas eram enormes, mas Michel e seus colegas miniaturizaram-na revestindo os microcanais fluídicos com um eletrólito catalisador.

Fonte: site Inovação Tecnológica

domingo, 11 de dezembro de 2011

Mecânica: Isolamento térmico fica mais fino e mais eficiente

Geladeiras com paredes super finas, carros que não esquentam tanto ao Sol e nem gastam tanta potência com ar-condicionado, e casas com um isolamento térmico tão fácil de instalar quanto um papel de parede.

Estas são algumas das promessas feitas por engenheiros do Instituto Fraunhofer, na Alemanha.

Sílica pirogênica

Klaus Noller e seus colegas criaram uma nova família de isolantes térmicos que são os mais finos e mais eficientes já fabricados.

O mais grosso e mais eficiente dos painéis com a nova tecnologia tem apenas 2 centímetros de espessura, mas oferece a mesma capacidade de isolamento térmico que uma camada de isolamento de 15 centímetros disponível no mercado, feita com espuma de poliuretano.

O segredo está em um material chamado sílica pirogênica e na criação de bolsas de vácuo no interior de painéis muito finos.

Os novos filmes são mais fáceis de fabricar e compostos por três camadas de barreiras térmico-isolantes: dois filmes plásticos recobertos com alumínio fazendo um sanduíche da camada que é a grande invenção dos engenheiros alemães, um material que eles batizaram de Ormocer®.

Acelerando o tempo

O novo material isolante contém uma matriz híbrida orgânica-inorgânica feita de óxido de silício, que é extremamente densa e virtualmente impenetrável por líquidos e até por gases.

"É isto que torna o material perfeito como isolante," diz o Dr. Noller. Gases e líquidos não conseguem penetrar facilmente essa camada. O produto final é melhor e mais barato do que os filmes isolantes existentes no mercado."

Agora os engenheiros estão submetendo o material a testes de durabilidade: enquanto uma geladeira só precisa durar 20 anos, a camada de proteção térmica de um edifício deve ser capaz de resistir durante pelo menos 50 anos.

Os testes de durabilidade e estabilidade estão sendo feitos dentro de câmaras climáticas, que simulam sucessivas alterações de estação para estação - os testes deverão serão concluídos em apenas alguns meses.

Fonte: Inovação Tecnológica

sexta-feira, 9 de dezembro de 2011

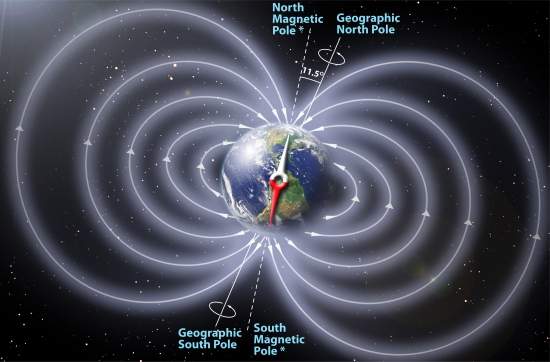

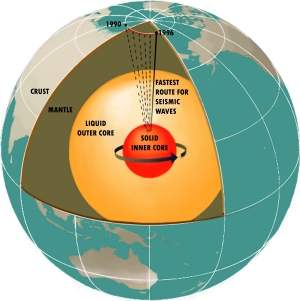

Meio Ambiente: Pólos magnéticos da Terra invertem o tempo todo - geologicamente falando

A inversão do campo magnético da Terra é um fenômeno contínuo, e que não produziu catástrofes sobre a vida no planeta no passado.

Aceleração da reversão

Os pólos magnéticos da Terra invertem-se o tempo todo - geologicamente falando.

Se você voltasse no tempo cerca de 800.000 anos, e levasse consigo uma bússola, descobriria que a ponta da agulha apontaria para o que hoje chamamos de sul.

Os geólogos sabem há muito tempo que os pólos magnéticos da Terra se invertem ao longo das eras.

O que eles não sabiam é que a inversão dos pólos é mais a regra do que a exceção, e que ela vem se acelerando.

No tempo dos dinossauros, os registros fósseis indicam que havia uma reversão dos pólos magnéticos a cada 1 milhão de anos. Nos tempos mais recentes, essa reversão tem ocorrido a cada 200.000 a 300.000 anos.

Por outro lado, já se passou mais do que o dobro desse tempo - 780.000 anos - desde a última reversão, sem que se saiba a razão para isso.

Inversão magnética contínua

Um grupo de cientistas da NASA agora descobriu também que o fenômeno da inversão nada tem de suave ou de rápido.

Ela ocorre ao longo de centenas ou milhares de anos.

Durante esse período, os campos magnéticos parecem se misturar, puxar e empurrar uns aos outros, com múltiplos "pólos" emergindo aqui e ali, nas mais diversas latitudes, até que a situação se equilibre novamente.

O pólo magnético da Terra está-se deslocando continuamente. Ele já se moveu 1.100 quilômetros desde que foi medido com precisão pela primeira vez, no século 19.

Esse deslocamento vem-se acentuando nos últimos anos: os pólos magnéticos estão migrando rumo ao norte geográfico a uma razão de cerca de 65 km por ano, contra cerca de 15 quilômetros por ano no início do século 20.

Sem catástrofes

Os cientistas conhecem o processo analisando a magnetização da lava conforme ela escorre dos vulcões, sobretudo submarinos - conforme a lava se solidifica, ela "grava" a orientação do campo magnético naquele momento.

Felizmente, os registros geológicos não mostram qualquer alteração drástica na vida vegetal ou animal nesses períodos.

Os dados também indicam que a reversão dos pólos magnéticos não guarda qualquer correlação com a atividade glacial.

Isto, segundo os cientistas, é uma prova de que a reversão da polaridade não afeta a inclinação do eixo de rotação da Terra, já que a alteração do eixo tem influências significativas sobre o clima e a glaciação.

Há hipóteses que consideram que a reversão geomagnética deixaria a Terra sem o campo magnético que nos protege das ejeções de massa coronal e das tempestades solares.

Mas os dados indicam que esse campo nunca desapareceu completamente, não gerando nenhuma influência catastrófica sobre a vida do planeta na época de cada inversão.

Fonte: Site Inovação Tecnológica

Tecnologia brasileira elimina poluentes industriais com energia solar

Sol e titânio

Pesquisadores da Unicamp criaram uma alternativa sustentável, viável economicamente, e altamente eficiente, para eliminar poluentes orgânicos da água.

A tecnologia usa energia solar para destruir os poluentes presentes na água, representando uma solução adequada para as áreas mais carentes não apenas do país, mas de todo o mundo.

A equipe da professora Cláudia Longo utilizou energia solar e nanopartículas de dióxido de titânio (TiO2), em uma tecnologia que está sendo patenteada para então ser desenvolvida em escala industrial para chegar ao mercado.

De acordo com a pesquisadora, os resultados obtidos nos experimentos realizados em escala laboratorial são promissores e indicam que o sistema pode ser aperfeiçoado e utilizado tanto para combater a poluição industrial quanto para dar melhores condições de vida para a população.

A tecnologia é adequada para a etapa final do tratamento de efluentes industriais, mas "também poderá ser utilizada para a purificação da água consumida por pessoas que vivem em regiões sem acesso a saneamento básico", aponta.

Energia solar contra poluentes orgânicos

Os pesquisadores desenvolveram um sistema que consiste na conexão de um eletrodo de TiO2 a células solares, resultando na combinação de duas aplicações da conversão da energia solar por meio de semicondutores.

Conforme explica Cláudia, a primeira aplicação resultante, e já bastante conhecida, é a conversão em energia elétrica. A outra se refere à purificação da água. O diferencial do trabalho é a combinação das duas, tornando o processo mais eficiente em relação às alternativas existentes.

Em relação ao tratamento de efluentes disponíveis atualmente, ela aponta algumas limitações, como custos elevados e o longo período necessário para a descontaminação.

Outro fator relevante inclui a baixa eficácia para eliminar diversos poluentes orgânicos solúveis, tais como fenol, pesticidas, corantes e medicamentos. Estes poluentes persistentes permanecem no ambiente por longos períodos, já que não são biodegradáveis.

Os testes em escala laboratorial mostraram resultados animadores em relação à eliminação justamente desse tipo de substância da água, com a degradação de 78% do fenol após três horas sob irradiação solar; após seis horas, mais de 90% do poluente foi mineralizado.

As substâncias investigadas pelo projeto incluem, além do fenol, o corante Rodamina 6G (utilizado na indústria têxtil) e os fármacos paracetamol e estradiol.

Saneamento sustentável

O sistema também tem grande potencial para desinfecção de água contaminada por bactérias.

Com a possibilidade de ampliação dos testes e aperfeiçoamento do sistema, o trabalho pode ter aplicação na etapa final do tratamento de efluentes, tendo como alvo estações de tratamento de efluentes de indústrias têxteis, de papel e celulose, petroquímicas e de agrotóxicos, por exemplo, bem como companhias de água e esgoto e estações de tratamento de efluentes em shopping centers, entre outros.

Cláudia ressalta ainda que o sistema aperfeiçoado também pode ser utilizado para purificação de água em comunidades afastadas, não atendidas pelo serviço básico de saneamento, eliminando contaminantes resistentes a tratamentos convencionais.

Outra vantagem do sistema é o fato de ser autossuficiente do ponto de vista energético, devido à utilização de radiação solar. Baixo custo e o fato de ser sustentável (não é poluente, não exige adição de insumos e não gera resíduos) completam a relação.

Pesquisadores da Unicamp criaram uma alternativa sustentável, viável economicamente, e altamente eficiente, para eliminar poluentes orgânicos da água.

A tecnologia usa energia solar para destruir os poluentes presentes na água, representando uma solução adequada para as áreas mais carentes não apenas do país, mas de todo o mundo.

A equipe da professora Cláudia Longo utilizou energia solar e nanopartículas de dióxido de titânio (TiO2), em uma tecnologia que está sendo patenteada para então ser desenvolvida em escala industrial para chegar ao mercado.

De acordo com a pesquisadora, os resultados obtidos nos experimentos realizados em escala laboratorial são promissores e indicam que o sistema pode ser aperfeiçoado e utilizado tanto para combater a poluição industrial quanto para dar melhores condições de vida para a população.

A tecnologia é adequada para a etapa final do tratamento de efluentes industriais, mas "também poderá ser utilizada para a purificação da água consumida por pessoas que vivem em regiões sem acesso a saneamento básico", aponta.

Energia solar contra poluentes orgânicos

Os pesquisadores desenvolveram um sistema que consiste na conexão de um eletrodo de TiO2 a células solares, resultando na combinação de duas aplicações da conversão da energia solar por meio de semicondutores.

Conforme explica Cláudia, a primeira aplicação resultante, e já bastante conhecida, é a conversão em energia elétrica. A outra se refere à purificação da água. O diferencial do trabalho é a combinação das duas, tornando o processo mais eficiente em relação às alternativas existentes.

Em relação ao tratamento de efluentes disponíveis atualmente, ela aponta algumas limitações, como custos elevados e o longo período necessário para a descontaminação.

Outro fator relevante inclui a baixa eficácia para eliminar diversos poluentes orgânicos solúveis, tais como fenol, pesticidas, corantes e medicamentos. Estes poluentes persistentes permanecem no ambiente por longos períodos, já que não são biodegradáveis.

Os testes em escala laboratorial mostraram resultados animadores em relação à eliminação justamente desse tipo de substância da água, com a degradação de 78% do fenol após três horas sob irradiação solar; após seis horas, mais de 90% do poluente foi mineralizado.

As substâncias investigadas pelo projeto incluem, além do fenol, o corante Rodamina 6G (utilizado na indústria têxtil) e os fármacos paracetamol e estradiol.

Saneamento sustentável

O sistema também tem grande potencial para desinfecção de água contaminada por bactérias.

Com a possibilidade de ampliação dos testes e aperfeiçoamento do sistema, o trabalho pode ter aplicação na etapa final do tratamento de efluentes, tendo como alvo estações de tratamento de efluentes de indústrias têxteis, de papel e celulose, petroquímicas e de agrotóxicos, por exemplo, bem como companhias de água e esgoto e estações de tratamento de efluentes em shopping centers, entre outros.

Cláudia ressalta ainda que o sistema aperfeiçoado também pode ser utilizado para purificação de água em comunidades afastadas, não atendidas pelo serviço básico de saneamento, eliminando contaminantes resistentes a tratamentos convencionais.

Outra vantagem do sistema é o fato de ser autossuficiente do ponto de vista energético, devido à utilização de radiação solar. Baixo custo e o fato de ser sustentável (não é poluente, não exige adição de insumos e não gera resíduos) completam a relação.

Eletricidade sem fios recarrega veículos elétricos rodando

Transporte verde

A Coreia do Sul não está satisfeita em colocar apenas seus carros em mercados do mundo todo.

Uma nova tecnologia de "transporte verde", criado por engenheiros do instituto KAIST, acaba de ser licenciada e deverá estrear brevemente nas ruas da cidade de McAllen, no estado do Texas (EUA).

O veículo, uma espécie de trólebus, foi categorizado pelos seus criadores como um OLEV (On-line Electric Vehicle).

Eletricidade sem fios

O "autobonde" é inteiramente elétrico, mas com um detalhe que pode fazer a diferença, e que responde pelo termo on-line em seu nome: ele não precisa parar para recarregar suas baterias.

A energia elétrica necessária para recarregar as baterias do OLEV é suprida continuamente sem fios, por meio de um campo magnético criado por fios instalados sob o asfalto.

Esse sistema de suprimento de eletricidade sem fios chama-se SMFIR - Shaped Magnetic Field in Resonance, campo magnético estruturado em ressonância, em tradução livre.

Os engenheiros coreanos afirmaram já estar trabalhando para adaptar esse sistema de recarga de baterias sem fios para outros tipos de veículos elétricos, para equipamentos eletrônicos e também para uso industrial.

Rodovia eletrônica

"Este projeto vai demonstrar a eficiência total de usar a tecnologia de recarregamento em trânsito para criar uma verdadeira 'rodovia eletrônica', assim como um meio barato de converter os ônibus a diesel atuais por veículos elétricos," disse Hikyu Lee, membro da equipe de desenvolvimento do OLEV.

O primeiro OLEV deverá estrear nas ruas de McAleen no início de 2013, já sem o aspecto de "trenzinho da alegria" visto nos protótipos.

A Alemanha também já apresentou o seu autobonde elétrico, que também dispensa os trilhos e os cabos dos trólebus, mas ainda depende do sistema tradicional de recarga das baterias.

Fonte: Site Inovação Tecnológica

A Coreia do Sul não está satisfeita em colocar apenas seus carros em mercados do mundo todo.

Uma nova tecnologia de "transporte verde", criado por engenheiros do instituto KAIST, acaba de ser licenciada e deverá estrear brevemente nas ruas da cidade de McAllen, no estado do Texas (EUA).

O veículo, uma espécie de trólebus, foi categorizado pelos seus criadores como um OLEV (On-line Electric Vehicle).

Eletricidade sem fios

O "autobonde" é inteiramente elétrico, mas com um detalhe que pode fazer a diferença, e que responde pelo termo on-line em seu nome: ele não precisa parar para recarregar suas baterias.

A energia elétrica necessária para recarregar as baterias do OLEV é suprida continuamente sem fios, por meio de um campo magnético criado por fios instalados sob o asfalto.

Esse sistema de suprimento de eletricidade sem fios chama-se SMFIR - Shaped Magnetic Field in Resonance, campo magnético estruturado em ressonância, em tradução livre.

Os engenheiros coreanos afirmaram já estar trabalhando para adaptar esse sistema de recarga de baterias sem fios para outros tipos de veículos elétricos, para equipamentos eletrônicos e também para uso industrial.

Rodovia eletrônica

"Este projeto vai demonstrar a eficiência total de usar a tecnologia de recarregamento em trânsito para criar uma verdadeira 'rodovia eletrônica', assim como um meio barato de converter os ônibus a diesel atuais por veículos elétricos," disse Hikyu Lee, membro da equipe de desenvolvimento do OLEV.

O primeiro OLEV deverá estrear nas ruas de McAleen no início de 2013, já sem o aspecto de "trenzinho da alegria" visto nos protótipos.

A Alemanha também já apresentou o seu autobonde elétrico, que também dispensa os trilhos e os cabos dos trólebus, mas ainda depende do sistema tradicional de recarga das baterias.

Fonte: Site Inovação Tecnológica

Em breve...........

Olá a todos!! Em breve teremos neste site, postagens sobre tecnologia, descobertas, novidades em geral. Aguardem!!!

Assinar:

Postagens (Atom)